Directive Yandex pentru fișierul robots txt. Acest lucru este important: sortarea regulilor înainte de procesare. Excluderea paginilor cu parametri dinamici

Majoritatea roboților sunt bine proiectați și nu cauzează probleme proprietarilor de site-uri web. Dar dacă botul a fost scris de un amator sau „ceva a mers prost”, atunci poate crea o încărcare semnificativă pe site-ul pe care îl accesează cu crawlere. Apropo, păianjenii nu intră deloc pe server ca niște viruși - pur și simplu solicită paginile de care au nevoie de la distanță (de fapt, acestea sunt analoge ale browserelor, dar fără funcția de vizualizare a paginii).

Robots.txt - directivă user-agent și roboți pentru motoarele de căutare

Robots.txt are o sintaxă foarte simplă, care este descrisă în detaliu, de exemplu, în Ajutor YandexȘi Ajutor Google. De obicei indică pentru ce bot de căutare sunt destinate următoarele directive: nume bot (" Agent utilizator"), permițând (" Permite") și interzicerea (" Nu permiteți"), iar „Sitemap” este, de asemenea, utilizat în mod activ pentru a indica motoarele de căutare exact unde se află fișierul hărții.

Standardul a fost creat cu destul de mult timp în urmă și ceva a fost adăugat mai târziu. Există directive și reguli de proiectare care vor fi înțelese doar de anumiți roboți. motoare de căutare. În RuNet, doar Yandex și Google sunt de interes, ceea ce înseamnă că ar trebui să vă familiarizați cu ajutorul lor pentru compilarea robots.txt în detaliu (am furnizat linkurile în paragraful anterior).

De exemplu, anterior era util ca motorul de căutare Yandex să indice că proiectul dvs. web este principalul într-o directivă specială „Gazdă”, pe care doar acest motor de căutare o înțelege (ei bine, și Mail.ru, deoarece căutarea lor este de la Yandex ). Adevărat, la începutul lui 2018 Yandex a anulat în continuare Host iar acum funcțiile sale, ca și ale altor motoare de căutare, sunt îndeplinite printr-o redirecționare 301.

Chiar dacă resursa dvs. nu are oglinzi, va fi util să indicați care opțiune de ortografie este cea principală - .

Acum să vorbim puțin despre sintaxa acestui fișier. Directivele din robots.txt arată astfel:

<поле>:<пробел><значение><пробел> <поле>:<пробел><значение><пробел>

Codul corect ar trebui să conțină cel puțin o directivă „Disallow”. după fiecare intrare „User-agent”. Fișier gol implică permisiunea de a indexa întregul site.

Agent utilizator

Directiva „User-agent”. trebuie să conțină numele botului de căutare. Folosind-o, puteți configura reguli de comportament pentru fiecare motor de căutare specific (de exemplu, creați o interdicție de indexare folder separat numai pentru Yandex). Un exemplu de scriere a „User-agent” adresat tuturor roboților care vă vizitează resursa arată astfel:

Agent utilizator: *

Dacă doriți să setați anumite condiții în „User-agent” doar pentru un bot, de exemplu, Yandex, atunci trebuie să scrieți acest lucru:

Agent utilizator: Yandex

Numele roboților motoarelor de căutare și rolul acestora în fișierul robots.txt

Botul fiecărui motor de căutare are propriul nume (de exemplu, pentru un rambler este StackRambler). Aici voi da o listă cu cele mai cunoscute dintre ele:

Google http://www.google.com Googlebot Yandex http://www.ya.ru Yandex Bing http://www.bing.com/ bingbot

Motoarele de căutare majore uneori cu excepția roboților principali, există și instanțe separate pentru indexarea blogurilor, știrilor, imaginilor etc. Puteți obține o mulțime de informații despre tipurile de roboți (pentru Yandex) și (pentru Google).

Cum să fii în acest caz? Dacă trebuie să scrieți o regulă pentru interzicerea indexării, pe care trebuie să o respecte toate tipurile de roboți Google, atunci folosiți numele Googlebot și toți ceilalți păianjeni ai acestui motor de căutare se vor supune și ei. Cu toate acestea, puteți interzice, de exemplu, indexarea imaginilor doar prin specificarea robotului Googlebot-Image ca User-agent. Acum acest lucru nu este foarte clar, dar cu exemple, cred că va fi mai ușor.

Exemple de utilizare a directivelor Disallow și Allow în robots.txt

Îți voi oferi câteva simple. exemple de utilizare a directivelor cu o explicație a acțiunilor sale.

- Codul de mai jos permite tuturor roboților (indicați printr-un asterisc în User-agent) să indexeze tot conținutul fără nicio excepție. Acesta este dat directivă goală Disallow. Agent utilizator: * Nu permite:

- Următorul cod, dimpotrivă, interzice complet tuturor motoarelor de căutare să adauge pagini din această resursă la index. Setează această opțiune la Disallow cu „/” în câmpul de valoare. Agent utilizator: * Nu permite: /

- În acest caz, tuturor roboților li se va interzice vizualizarea conținutului directorului /image/ (http://mysite.ru/image/ - cale absolută la acest director) User-agent: * Disallow: /image/

- Pentru a bloca un fișier, va fi suficient să-i înregistrați calea absolută către el (citiți): User-agent: * Disallow: /katalog1//katalog2/private_file.html

Privind puțin înainte, voi spune că este mai ușor să folosiți simbolul asterisc (*) pentru a nu scrie calea plină:

Nu permiteți: /*fișier_privat.html

- În exemplul de mai jos, directorul „image” va fi interzis, precum și toate fișierele și directoarele care încep cu caracterele „image”, adică fișierele: „image.htm”, „images.htm”, directoare: „image”, „ images1”, „image34”, etc.): User-agent: * Disallow: /image Faptul este că implicit la sfârșitul intrării există un asterisc, care înlocuiește orice caractere, inclusiv absența acestora. Citiți mai jos despre asta.

- Prin utilizarea Permite directive permitem accesul. Complementele Renunță bine. De exemplu, cu această condiție, interzicem robotului de căutare Yandex să descarce (indexeze) totul, cu excepția paginilor web a căror adresă începe cu /cgi-bin: User-agent: Yandex Allow: /cgi-bin Disallow: /

Ei bine, sau acest exemplu evident de utilizare a combinației Permite și Nu permite:

Agent utilizator: * Disallow: /catalog Allow: /catalog/auto

- Când descrieți căile pentru directivele Allow-Disallow, puteți utiliza simbolurile „*” și „$”, definind astfel anumite expresii logice.

- Simbol "*"(stea)înseamnă orice secvență de caractere (inclusiv goală). Următorul exemplu interzice tuturor motoarelor de căutare să indexeze fișiere cu extensia „.php”: User-agent: * Disallow: *.php$

- De ce este nevoie la final? semnul $? Cert este că conform logicii compilației fișier roboți.txt, la sfârșitul fiecărei directive este adăugat un asterisc implicit (nu este acolo, dar pare să fie acolo). De exemplu, scriem: Disallow: /images

Dând de înțeles că acesta este același cu:

Nu permiteți: /imagini*

Acestea. această regulă interzice indexarea tuturor fișierelor (pagini web, imagini și alte tipuri de fișiere) a căror adresă începe cu /imagini și apoi urmează orice (vezi exemplul de mai sus). Asa de, simbolul $ pur și simplu anulează asteriscul implicit de la sfârșit. De exemplu:

Nu permiteți: /imagini$

Previne doar indexarea fișierului /images, dar nu și /images.html sau /images/primer.html. Ei bine, în primul exemplu, am interzis indexarea doar a fișierelor care se termină în .php (având o astfel de extensie), pentru a nu prinde nimic inutil:

Nu permite: *.php$

Asteriscul de după semnul întrebării se sugerează de la sine, dar, după cum am aflat chiar mai sus, este deja subînțeles la sfârșit. Astfel, vom interzice indexarea paginilor de căutare și a altor pagini de servicii create de motor, la care robotul de căutare poate ajunge. Nu va fi de prisos, deoarece semnul de întrebare este cel mai des folosit de CMS ca identificator de sesiune, ceea ce poate duce la includerea paginilor duplicate în index.

Sitemap și directive gazdă (pentru Yandex) în Robots.txt

Pentru a evita apariția probleme neplăcute cu oglinzile site-ului, anterior se recomanda adăugarea unei directive Gazdă la robots.txt, care îndrepta botul Yandex către oglinda principală.

Directiva gazdă - indică oglinda principală a site-ului pentru Yandex

De exemplu, mai devreme dacă tu nu au trecut încă la un protocol securizat, a fost necesar să se indice în Gazdă nu URL-ul complet, dar Numele domeniului(fără http://, adică ru). Dacă ați trecut deja la https, atunci va trebui să indicați adresa URL completă (cum ar fi https://myhost.ru).

Un instrument minunat pentru combaterea conținutului duplicat - motorul de căutare pur și simplu nu va indexa pagina dacă o adresă URL diferită este înregistrată în Canonical. De exemplu, pentru o astfel de pagină a blogului meu (pagină cu paginare), Canonical indică https://site și nu ar trebui să existe probleme cu duplicarea titlurilor.

Dar mă abat...

Dacă proiectul dvs. este creat pe baza oricărui motor, atunci Va apărea conținut duplicat cu o probabilitate mare, ceea ce înseamnă că trebuie să îl combateți, inclusiv cu ajutorul unui ban în robots.txt, și mai ales în metaeticheta, pentru că în primul caz interzicerea Google s-ar putea să-l ignore, dar nu va fi capabil să dea doi bani pe metaetichetă (așa a fost crescut).

De exemplu, în Pagini WordPress cu conținut foarte asemănător pot fi incluse în indexul motorului de căutare dacă este permisă indexarea conținutului categoriilor, a conținutului arhivei de etichete și a conținutului arhivelor temporare. Dar dacă, folosind metaeticheta Robots descrisă mai sus, creați o interdicție a arhivei de etichete și a arhivei temporare (puteți lăsa etichetele și interzice indexarea conținutului categoriilor), atunci duplicarea conținutului nu va avea loc. Cum se face acest lucru este descris în linkul dat chiar mai sus (la pluginul OlInSeoPak)

Pentru a rezuma, voi spune că fișierul Robots este destinat sarcinii reguli globale interzicerea accesului la directoare întregi ale site-ului sau la fișiere și foldere ale căror nume conțin caractere date(cu mască). Puteți vedea exemple de stabilire a unor astfel de interdicții chiar mai sus.

Acum să aruncăm o privire exemple concrete roboți proiectați pentru diferite motoare - Joomla, WordPress și SMF. Desigur, toate cele trei opțiuni create pentru diferite CMS vor diferi semnificativ (dacă nu radical) una de cealaltă. Adevărat, toate vor avea un lucru în comun, iar acest moment este conectat cu motorul de căutare Yandex.

Deoarece În RuNet, Yandex are o greutate destul de mare, atunci trebuie să luăm în considerare toate nuanțele muncii sale și aici Directiva gazdă vă va ajuta. Acesta va indica în mod explicit acestui motor de căutare oglinda principală a site-ului dvs.

Pentru aceasta, este recomandat să folosiți un blog separat pentru User-agent, destinat numai Yandex (User-agent: Yandex). Acest lucru se datorează faptului că alte motoare de căutare ar putea să nu înțeleagă Host și, în consecință, includerea acesteia în înregistrarea User-agent destinată tuturor motoarelor de căutare (User-agent: *) poate duce la consecințe negative și la indexare incorectă.

Este greu de spus care este situația cu adevărat, deoarece algoritmii de căutare sunt un lucru în sine, așa că este mai bine să procedați conform recomandărilor. Dar, în acest caz, va trebui să duplicăm în directiva User-agent: Yandex toate regulile pe care le setăm User-agent: *. Dacă părăsiți User-agent: Yandex cu un Disallow: gol, atunci în acest fel îi veți permite lui Yandex să meargă oriunde și să trageți totul în index.

Roboți pentru WordPress

Nu voi da un exemplu de fișier pe care dezvoltatorii îl recomandă. Îl poți urmări singur. Mulți bloggeri nu limitează deloc roboții Yandex și Google în plimbările lor prin conținutul motorului WordPress. Cel mai adesea pe bloguri puteți găsi roboți umpluți automat cu un plugin.

Dar, după părerea mea, ar trebui să ajutăm totuși căutarea în grea sarcină de a cerne grâul din pleavă. În primul rând, roboții Yandex și Google vor avea nevoie de mult timp pentru a indexa acest gunoi și este posibil să nu mai rămână timp pentru a adăuga pagini web cu noile articole la index. În al doilea rând, roboții urcă fișiere nedorite motorul va crea încărcare suplimentară pe serverul gazdei dvs., ceea ce nu este bun.

Puteți vedea singur versiunea mea a acestui fișier. Este vechi și nu a fost schimbat de mult timp, dar încerc să urmez principiul „nu repara ceea ce nu este stricat” și ține de tine să decizi: folosește-l, fă-ți singur sau furi din altcineva. De asemenea, am avut până de curând interdicție de indexare a paginilor cu paginare (Disallow: */page/), dar recent am eliminat-o, bazându-mă pe Canonical, despre care am scris mai sus.

Dar în general, numai fisierul corect pentru WordPress probabil că nu există. Puteți, desigur, să implementați orice cerințe prealabile în ea, dar cine a spus că vor fi corecte. Există multe opțiuni pentru robots.txt ideal pe Internet.

Voi da două extreme:

- puteți găsi un mega fișier cu explicații detaliate (simbolul # separă comentariile care ar fi mai bine șterse într-un fișier real): User-agent: * # reguli generale pentru roboți, cu excepția Yandex și Google, # deoarece pentru ei regulile sunt mai jos Disallow: /cgi-bin # folder on hosting Disallow: /? # toți parametrii de solicitare de pe pagina principală Disallow: /wp- # toate fișierele WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: /wp/ # dacă există un subdirector /wp/ unde CMS-ul este instalat (dacă nu, # regula poate fi ștearsă) Disallow: *?s= # search Disallow: *&s= # search Disallow: /search/ # search Disallow: /author/ # author archive Disallow: /users/ # arhiva autorului Disallow: */ trackback # trackback-uri, notificări în comentarii despre apariția unui # link deschis către un articol Disallow: */feed # toate feedurile Disallow: */rss # rss feed Disallow: */embed # all embeddings Disallow : */wlwmanifest.xml # fișier xml manifest Windows Live Scriitor (dacă nu o utilizați, # regula poate fi ștearsă) Disallow: /xmlrpc.php # WordPress API file Disallow: *utm= # link-uri cu etichete utm Disallow: *openstat= # link-uri cu etichete openstat Permite: * /uploads # deschide folderul cu fișierele de încărcare User-agent: GoogleBot # reguli pentru Google (nu dublez comentarii) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */ rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /*/*.js # open js scripts inside /wp - (/*/ - pentru prioritate) Permite: /*/*.css # deschide fișiere CSS în /wp- (/*/ - pentru prioritate) Permite: /wp-*.png # imagini în pluginuri, folderul cache și etc. Permite: /wp-*.jpg # imagini în pluginuri, folderul cache etc. Permite: /wp-*.jpeg # imagini în pluginuri, folderul cache etc. Permite: /wp-*.gif # imagini în pluginuri, folderul cache etc. Permite: /wp-admin/admin-ajax.php # folosit de pluginuri pentru a nu bloca JS și CSS User-agent: Yandex # reguli pentru Yandex (nu dublez comentarii) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */ rss Nu permite: */embed Nepermite: */wlwmanifest.xml Permite: /xmlrpc.php Permite: */încărcări Permite: /*/*.js Permite: /*/*.css Permite: /wp-*.png Permite: /wp-*.jpg Permite: /wp-*.jpeg Permite: /wp-*.gif Permite: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign # Yandex recomandă să nu blochezi # de la indexare, ci ștergerea parametrii etichetei, # Google nu acceptă astfel de reguli Clean-Param: openstat # similar # Specificați unul sau mai multe Fișiere sitemap(nu este nevoie de duplicat pentru fiecare User-agent #). Google Sitemap XML creează 2 sitemap-uri, ca în exemplul de mai jos. Harta site-ului: http://site.ru/sitemap.xml Harta site-ului: http://site.ru/sitemap.xml.gz # Specificați oglinda principală a site-ului, ca în exemplul de mai jos (cu WWW / fără WWW, dacă HTTPS # apoi scrieți protocolul, dacă trebuie să specificați un port, indicați-l). Comanda Gazdă este înțeleasă de # Yandex și Mail.RU, Google nu o ia în considerare. Gazdă: www.site.ru

- Dar puteți folosi un exemplu de minimalism: User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Gazdă: https://site.ru Sitemap: https://site. ru/sitemap.xml

Adevărul se află probabil undeva la mijloc. De asemenea, nu uitați să adăugați metaeticheta Robots pentru paginile „extra”, de exemplu, folosind minunatul plugin - . De asemenea, vă va ajuta să configurați Canonical.

Robots.txt corect pentru Joomla

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/

În principiu, aici se ia în calcul aproape totul și funcționează bine. Singurul lucru este că ar trebui să adăugați o regulă separată User-agent: Yandex pentru a introduce directiva Gazdă, care definește oglinda principală pentru Yandex și, de asemenea, specifica calea către fișierul Sitemap.

Prin urmare, în forma finală roboți corecti pentru Joomla, în opinia mea, ar trebui să arate așa:

Agent utilizator: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /component/tags* Disallow: /*mailto/ Disallow: /*.pdf Disallow : /*% Disallow: /index.php Gazdă: vash_sait.ru (sau www.vash_sait.ru) User-agent: * Permite: /*.css?*$ Permite: /*.js?*$ Permite: /* .jpg?*$ Permite: /*.png?*$ Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /modules/ Disallow : /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /*mailto/ Disallow: /*. pdf Disallow: /*% Disallow: /index.php Sitemap: http://path to your Harta XML format

Da, rețineți că în a doua opțiune există directive Permite, permițând indexarea stilurilor, scripturilor și imaginilor. Acest lucru a fost scris special pentru Google, deoarece Googlebot-ul său se plânge uneori că indexarea acestor fișiere, de exemplu, din folderul cu tema folosită, este interzisă în roboți. Ba chiar amenință că își va coborî clasamentul pentru asta.

Prin urmare, permitem ca întregul lucru să fie indexat în avans folosind Allow. Apropo, același lucru s-a întâmplat în fișierul exemplu pentru WordPress.

Multă baftă! Inainte de pe curând pe paginile site-ului blogului

Puteți viziona mai multe videoclipuri accesând");">S-ar putea să fiți interesat

Domenii cu și fără www - istoricul apariției lor, utilizarea redirecționărilor 301 pentru a le lipi împreună

Oglinzi, pagini duplicate și adrese URL- auditul site-ului dvs. sau ceea ce ar putea cauza eșec în timpul promovării sale SEO

Bună ziua, dragi cititori ai blogului „Webmaster’s World”!

Fişier robots.txt- aceasta este foarte dosar important, care afectează direct calitatea indexării site-ului dvs. și, prin urmare, a acestuia promovarea motorului de căutare.

De aceea trebuie să puteți formata corect robots.txt pentru a nu interzice accidental să fie incluse în index orice documente importante ale proiectului Internet.

Cum să formatați fișierul robots.txt, ce sintaxă ar trebui utilizată, cum să permiteți și să refuzați documentele în index vor fi discutate în acest articol.

Despre fișierul robots.txt

Mai întâi, să aflăm mai detaliat ce fel de fișier este acesta.

File roboți este un fișier care arată motoarelor de căutare ce pagini și documente de pe un site pot fi adăugate la index și care nu. Este necesar pentru că inițial motoarele de căutare încearcă să indexeze întregul site, iar acest lucru nu este întotdeauna corect. De exemplu, dacă creați un site pe un motor (WordPress, Joomla etc.), atunci veți avea foldere care organizează munca panoul administrativ. Este clar că informațiile din aceste foldere nu pot fi indexate în acest caz, se folosește fișierul robots.txt, care restricționează accesul la motoarele de căutare.

Fișierul robots.txt conține și adresa sitemap-ului (îmbunătățește indexarea de către motoarele de căutare), precum și domeniul principal site-ul web (oglindă principală).

Oglindă– aceasta este o copie absolută a site-ului, adică când există un site, atunci ei spun că unul dintre ele este domeniul principal, iar celălalt este oglinda lui.

Astfel, fișierul are o mulțime de funcții și chiar importante!

Sintaxa fișierului Robots.txt

Fișierul roboți conține blocuri de reguli care spun unui anumit motor de căutare ce poate fi indexat și ce nu. Poate exista un singur bloc de reguli (pentru toate motoarele de căutare), dar pot exista și mai multe dintre ele - pentru anumite motoare de căutare separat.

Fiecare astfel de bloc începe cu un operator „User-Agent”, care indică la ce motor de căutare se aplică aceste reguli.

Utilizator-Agent:A

(reguli pentru robotul „A”)

Utilizator-Agent:B

(reguli pentru robotul „B”)

Exemplul de mai sus arată că operatorul „User-Agent” are un parametru - numele robotului motorului de căutare căruia i se aplică regulile. Pe cele principale le voi indica mai jos:

După „User-Agent” există alți operatori. Iată descrierea lor:

Toți operatorii au aceeași sintaxă. Acestea. operatorii trebuie utilizați după cum urmează:

Operator1: parametrul1

Operator2: parametrul2

…

Astfel, mai întâi scriem numele operatorului (indiferent cu majuscule sau mici), apoi punem două puncte și, despărțiți de un spațiu, indicăm parametrul acestui operator. Apoi cu linie nouă descriem operatorul doi în același mod.

Important!!! Linie goală va însemna că blocul de reguli pentru acest motor de căutare este complet, așa că nu separați declarațiile cu o linie goală.

Exemplu de fișier robots.txt

Să ne uităm la un exemplu simplu de fișier robots.txt pentru a înțelege mai bine caracteristicile sintaxei acestuia:

Agent utilizator: Yandex

Permite: /folder1/

Nu permiteți: /file1.html

Gazdă: www.site.ru

Agent utilizator: *

Nu permiteți: /document.php

Nu permiteți: /folderxxx/

Nu permiteți: /folderyyy/folderzzz

Nu permiteți: /feed/

Harta site-ului: http://www.site.ru/sitemap.xml

Acum să ne uităm la exemplul descris.

Fișierul este format din trei blocuri: primul pentru Yandex, al doilea pentru toate motoarele de căutare, iar al treilea conține adresa sitemap (aplicată automat pentru toate motoarele de căutare, deci nu este nevoie să specificați „User-Agent”). Am permis lui Yandex să indexeze folderul „folder1” și tot conținutul acestuia, dar i-am interzis să indexeze documentul „file1.html” aflat în directorul rădăcină de pe găzduire. De asemenea, i-am indicat Yandex domeniul principal al site-ului. Al doilea bloc este pentru toate motoarele de căutare. Acolo am interzis documentul „document.php”, precum și folderele „folderxxx”, „folderyyy/folderzzz” și „feed”.

Vă rugăm să rețineți că în al doilea bloc de comenzi la index nu am interzis întregul folder „folderyyy”, ci doar folderul din interiorul acestui folder – „folderzzz”. Acestea. am furnizat calea completă pentru „folderzzz”. Acest lucru ar trebui făcut întotdeauna dacă interzicem un document aflat nu în directorul rădăcină al site-ului, ci undeva în alte foldere.

Va dura mai puțin de două minute pentru a crea:

Creată fișier roboți Puteți verifica funcționalitatea în panoul pentru webmasteri Yandex. Dacă erorile sunt găsite brusc în fișier, Yandex le va afișa.

Asigurați-vă că creați un fișier robots.txt pentru site-ul dvs. dacă nu aveți deja unul. Acest lucru va ajuta site-ul dvs. să se dezvolte în motoarele de căutare. Puteți citi și celălalt articol al nostru despre metoda meta-tagurilor și .htaccess.

) putem trece la partea practică, sau mai degrabă la pregătirea site-ului pentru promovare. Astăzi ne vom uita la întrebarea: cum se creează robots.txt?

robots.txt este un fișier care conține parametri de indexare pentru motoarele de căutare.

Crearea acestui fișier este unul dintre primii pași pentru promovarea SEO. Si de aceea.

Pentru ce este robots.txt?

După ce vă adăugați site-ul la Yandex și Google (nu am trecut încă prin asta), PS va începe să indexeze totul, absolut tot ce se află în folderul site-ului dvs. de pe server. Acest lucru nu este foarte bun din punct de vedere al promovării, deoarece folderul conține o mulțime de „gunoaie” care nu sunt necesare pentru PS, ceea ce va afecta negativ pozițiile în rezultatele căutării.

Este fișierul robots.txt care interzice indexarea documentelor, folderelor și pagini inutile. Printre altele, aceasta indică calea către harta site-ului (subiectul lecției următoare) și adresa principală, cam mai mult.

Nu voi vorbi prea mult despre sitemap, voi spune doar un lucru: un sitemap îmbunătățește indexarea site-ului. Dar merită să vorbim mai detaliat despre adresa principală. Faptul este că fiecare site are inițial mai multe oglinzi (copii ale site-ului) și sunt disponibile la diferite adrese:

- www.site

- site-ul web

- site/

- www.site/

Cu toate aceste oglinzi, site-ul nu devine unic. Desigur, PS-urilor nu le place conținutul non-unic, împiedicând astfel de site-uri să apară în rezultatele căutării.

Cum se completează fișierul robots.txt?

Orice fișier conceput să funcționeze cu diverse servicii externe, în cazul nostru motoarele de căutare, trebuie să aibă reguli de completare (sintaxă). Iată regulile pentru roboți:

- Numele fișierului robots.txt trebuie să înceapă cu o literă mică. Nu trebuie să-l numiți Robots.txt sau ROBOTS.TXT. Dreapta: robots.txt;

- Format text Unix. Formatul este tipic blocnotes obișnuit pe Windows, deci crearea robots.txt este destul de simplă;

Operatori de roboți

Acum să vorbim despre operatorii roboți înșiși. Sunt aproximativ 6 în total, după părerea mea, dar sunt necesare doar 4:

- Agent utilizator. Acest operator folosit pentru a specifica motorul de căutare căruia îi sunt adresate regulile de indexare. Poate fi folosit pentru a indica reguli diferite PS diferit. Exemplu de completare: User-agent: Yandex;

- Nu permiteți. Un operator care interzice indexarea unui anumit folder, pagină sau fișier. Exemplu de completare: Disallow: /page.html;

- Gazdă. Acest operator indică adresa principală (domeniul) site-ului. Exemplu de completare: Gazdă: site web;

- Harta site-ului. Indică adresa sitemapului. Exemplu de completare: Sitemap: site/sitemap.xml;

Astfel, i-am interzis Yandex să indexeze pagina „pagină..” Acum robotul de căutare Yandex va ține cont de aceste reguli, iar pagina „page.html” nu va fi niciodată în index.

Agent utilizator

După cum sa menționat mai sus, User-agent specifică motorul de căutare căruia i se vor aplica regulile de indexare. Iată un mic semn:

| Sistem de căutare | Parametru utilizator-agent |

| Yandex | Yandex |

| Mail.ru | Mail.ru |

| Hoinar | StackRambler |

Dacă doriți ca regulile de indexare să se aplice tuturor PS-urilor, atunci trebuie să faceți următoarea intrare:

Agent utilizator: *

Adică, utilizați un asterisc obișnuit ca parametru.

Nu permiteți

Acest operator este puțin mai complicat, așa că trebuie să aveți grijă cum îl completați. Este scris după operatorul „User-agent”. Orice greșeală poate duce la consecințe foarte dezastruoase.

| Ce interzicem? | Parametru | Exemplu |

| Indexarea site-ului | / | Nu permite: / |

| Fișier în directorul rădăcină | /nume de fișier | Nu permiteți: /page.html |

| Fișier la o anumită adresă | /cale/nume fișier | Nu permiteți: /dir/page.html |

| Indexarea unui folder | /numele fisierului/ | Nu permiteți: /folder/ |

| Indexarea unui folder la o anumită adresă | /cale/nume folder/ | Nu permiteți: /dir/papka/ |

| Documente incepand cu un anumit set personaje | /personaje | /simboluri |

| Documente care încep cu un anumit set de caractere la adresa | /cale/caractere | /dir/simboluri |

Zic din nou: fiți extrem de atenți când lucrați cu acest operator. De asemenea, se întâmplă că, pur întâmplător, o persoană interzice indexarea site-ului său și apoi este surprinsă că nu este în căutare.

Nu are rost să vorbim despre alți operatori. Ceea ce este scris mai sus este destul.

Poate ați dori un exemplu de robots.txt? Captură:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: / trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /tag Gazdă: site.ru Sitemap:site.ru/sitemap.xml

Apropo, acest exemplu poate fi folosit ca fișier robots.txt real de către persoanele ale căror site-uri rulează pe WordPress. Ei bine, cei care au site-uri web obișnuite, scrieți-le singuri, ha ha ha. Din păcate, nu există un singur lucru pentru fiecare; Dar cu informațiile pe care ți le-am oferit, crearea robots.txt nu ar trebui să fie prea dificilă.

La revedere prieteni!

Articolul anteriorArticolul următor

Fişier robots.txt este un fișier obișnuit cu extensia .txt, care poate fi creat folosind un fișier obișnuit Blocnotes Windows. Acest fișier conţine instrucţiuni de indexare pentru roboți de căutare. Plasați acest fișier director rădăcină pe găzduire.

Când un robot de căutare intră pe un site, primul lucru pe care îl face este să se uite la fișierul robots.txt pentru a primi instrucțiuni pentru acțiune ulterioarăși aflați ce fișiere și directoare nu au acces la indexare. Fişier robots.txt este de natură consultativă pentru motoarele de căutare. Nu se poate spune cu certitudine absolută că toate fișierele care sunt interzise de la indexare nu vor fi indexate în final.

Sa luam in considerare cel mai simplu exemplu fișierul robots.txt. Acest fișier conține următoarele rânduri:

User-agent: * Disallow: /wp-admin/ Disallow: /images/

Prima linie indică pentru ce roboți de căutare se aplică aceste instrucțiuni. ÎN în acest exemplu este indicat un asterisc - asta înseamnă că instrucțiunile se aplică tuturor roboților de căutare. Dacă trebuie să furnizați instrucțiuni pentru un anumit robot de căutare, trebuie să introduceți numele acestuia. Al doilea și al treilea rând interzic indexarea directoarelor „wp-admin” și „images”.

Pentru robotul de căutare Yandex, este, de asemenea, important să înregistrați directorul Gazdă pentru a indica oglinda principală a site-ului:

Agent utilizator: Yandex Disallow: /wp-admin/ Disallow: /images/ Gazdă: yoursite.ru

Exemple de scriere a unui fișier robots.txt pentru sarcini specifice

1. Nu interziceți roboților niciunui motoare de căutare să indexeze site-ul:

Agent de utilizator: googlebot Disallow: /

4. Nu interziceți indexarea de către un singur robot (de exemplu, googlebot) și interziceți indexarea tuturor celorlalți roboți de căutare:

Agent utilizator: googlebot Renunțare:

User-agent: * Disallow: /admin/ Disallow: /wp-content/ Disallow: /images/

Agent de utilizator: * Disallow: /News/webnews.html Disallow: /content/page.php

Agent de utilizator: * Disallow: /page.php Disallow: /links.htm Disallow: /secret.html

Reguli de bază pentru scrierea robots.txt

Greșeli sunt adesea făcute la scrierea fișierului robots.txt. Pentru a le evita, să ne uităm la regulile de bază:

1. Conținutul dosarului trebuie scris numai cu majuscule.

2. Declarația Disallow trebuie să specifice un singur director sau un fișier.

3. Linia „User-agent” nu trebuie să fie goală. Dacă instrucțiunile se aplică tuturor roboților de căutare, atunci trebuie să indicați un asterisc, iar dacă se aplică unui anumit robot de căutare, atunci indicați numele acestuia.

4. Instrucțiunile Disallow și User-agent nu pot fi schimbate.

5. În directiva Gazdă, care este utilizată pentru Yandex, adresa site-ului nostru trebuie specificată fără Protocolul HTTPși fără o tăietură de închidere.

6. Când interziceți indexarea directoarelor, este necesar să includeți bare oblice.

7. Ar trebui să verificați fișierul robots.txt înainte de a-l încărca pe server. Acest lucru va evita viitorul posibile probleme cu indexarea site-ului.

Robots.txt- Acest fisier text, care contine Instrucțiuni Speciale pentru roboții motoarelor de căutare care explorează site-ul dvs. pe Internet. Aceste instrucțiuni sunt numite directive— poate interzice indexarea unor pagini ale site-ului, poate indica „oglindirea” corectă a domeniului etc.

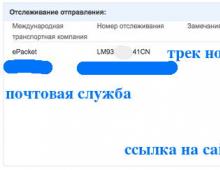

Pentru site-urile care rulează pe platforma Nubex, un fișier cu directive este creat automat și se află la domen.ru/robots.txt, unde domen.ru este numele de domeniu al site-ului..ru/robots.txt.

Puteți modifica robots.txt și puteți adăuga directive suplimentare pentru motoarele de căutare în zona de administrare a site-ului. Pentru a face acest lucru, selectați secțiunea de pe panoul de control „Setări”, și în el există un punct „SEO”.

Găsiți câmpul „Textul fișierului robots.txt”și notează în el directivele necesare. Este recomandabil să activați caseta de selectare „Adăugați un link către un fișier sitemap.xml generat automat în robots.txt”: astfel botul de căutare va putea să încarce harta site-ului și să găsească toate paginile necesare pentru indexare.

Directive de bază pentru fișierul robots txt

Când încarcă robots.txt, robotul de căutare caută mai întâi o intrare care începe cu Agent utilizator: Valoarea acestui câmp trebuie să fie numele robotului ale cărui drepturi de acces sunt setate în această intrare. Acestea. Directiva User-agent este un fel de apel către robot.

1. Dacă valoarea câmpului User-agent conține simbolul " * ", atunci drepturile de acces specificate în această intrare se aplică oricăror roboți de căutare care solicită fișierul /robots.txt.

2. Dacă într-o intrare sunt specificate mai multe nume de robot, atunci drepturile de acces se aplică tuturor numelor specificate.

3. Caracterele mari sau mici nu contează.

4. Dacă este detectat șirul User-agent: BotName, directivele pentru User-agent: * nu sunt luate în considerare (asta dacă faceți mai multe intrări pentru diverși roboți). Acestea. robotul va scana mai întâi textul pentru prezența intrării User-agent: MyName, iar dacă îl găsește, va urma aceste instrucțiuni; dacă nu, va acționa conform instrucțiunilor din intrarea User-agent: * (pentru toți roboții).

Apropo, este recomandat să introduceți un avans de linie gol (Enter) înainte de fiecare nouă directivă User-agent.

5. Dacă liniile User-agent: BotName și User-agent: * lipsesc, se consideră că accesul robotului nu este limitat.

Interzicerea și permiterea indexării site-urilor: directivele Disallow și Allow

Pentru a interzice sau a permite accesul roboților de căutare la anumite pagini site, se folosesc directive Nu permitețiȘi Permite respectiv.

Sensul acestor directive indică calea completă sau parțială către secțiune:

- Nu permiteți: /admin/— interzice indexarea tuturor paginilor situate în interiorul secțiunii admin;

- Nu permiteți: /help— interzice indexarea atât a /help.html, cât și a /help/index.html;

- Nu permiteți: /help/ —închide doar /help/index.html;

- Nu permite: /— blochează accesul la întregul site.

Dacă nu este specificată valoarea Disallow, atunci accesul nu este limitat:

- Nu permiteți:— este permisă indexarea tuturor paginilor site-ului.

Puteți utiliza directiva allow pentru a configura excepții Permite. De exemplu, o astfel de intrare va interzice roboților să indexeze toate secțiunile site-ului, cu excepția celor a căror cale începe cu /search:

Nu contează în ce ordine vor fi enumerate directivele pentru interzicerea și permiterea indexării. Când citește, robotul le va sorta în continuare după lungimea prefixului URL (de la cel mai mic la cel mai mare) și le va aplica secvenţial. Adică, exemplul de mai sus în percepția botului va arăta astfel:

— numai paginile care încep cu /search pot fi indexate. Astfel, ordinea directivelor nu va afecta în niciun fel rezultatul.

Directiva gazdă: cum să specificați domeniul principal al site-ului

Dacă site-ului dvs. sunt asociate mai multe nume de domenii (adrese tehnice, oglinzi etc.), motorul de căutare poate decide că acestea sunt toate site-uri diferite. Și cu același conținut. Soluţie? Interzice! Și un bot știe ce domeniu va fi „pedepsit” - cel principal sau cel tehnic.

Pentru a evita această problemă, trebuie să spuneți robotului de căutare la ce adresă site-ul dvs. participă la căutare. Această adresă va fi desemnată ca fiind cea principală, iar restul va forma un grup de oglinzi ale site-ului dvs.

Acest lucru se poate face folosind Directive gazdă. Acesta trebuie adăugat la intrarea începând cu User-Agent, imediat după directivele Disallow și Allow. În valoarea directivei Gazdă, trebuie să specificați domeniul principal cu numărul portului (80 în mod implicit). De exemplu:

Gazdă: test-o-la-la.ru

O astfel de intrare înseamnă că site-ul va fi afișat în rezultatele căutării cu un link către domeniul test-o-la-la.ru, și nu www.test-o-la-la.ru și s10364.. captură de ecran de mai sus).

În constructorul Nubex, directiva Host este adăugată automat textului fișierului robots.txt atunci când specificați în panoul de administrare care domeniu este cel principal.

În textul robots.txt, directiva gazdă poate fi folosită o singură dată. Dacă îl scrieți de mai multe ori, robotul va accepta doar prima intrare în ordine.

Directiva privind întârzierea cu crawlere: cum să setați intervalul de încărcare a paginii

Pentru a indica robotului intervalul minim dintre terminarea încărcării unei pagini și începerea încărcării următoarei, utilizați Directiva privind întârzierea cu crawler. Acesta trebuie adăugat la intrarea începând cu User-Agent, imediat după directivele Disallow și Allow. În valoarea directivei, specificați timpul în secunde.

Utilizarea unei astfel de întârzieri la procesarea paginilor va fi convenabilă pentru serverele supraîncărcate.

Există și alte directive pentru roboții de căutare, dar cele cinci descrise - User-Agent, Disallow, Allow, Host and Crawl-întârziere - de obicei suficient pentru a compune textul fișierului robots.txt.