Exploatarea datelor · Loginom Wiki. Tehnologia Data Mining Conceptul de data mining a devenit popular în

Ministerul Educației și Științei al Federației Ruse

Instituția de învățământ de învățământ profesional superior bugetar de stat federal

„UNIVERSITATEA POLITEHNICĂ TOMSK DE CERCETARE NAȚIONALĂ”

Institutul de Cibernetică

Directia Informatica si Informatica

Departamentul de VT

Test

la disciplina informatică și inginerie informatică

Subiect: Metode de extragere a datelor

Introducere

Exploatarea datelor. Concepte de bază și definiții

1 Pași în procesul de extragere a datelor

2 Componente ale sistemelor inteligente de analiză

3 Metode de extragere a datelor

Metode de extragere a datelor

1 Derivarea regulilor de asociere

2 algoritmi de rețea neuronală

3 Metodele celui mai apropiat vecin și k-nearest neighbors

4 Arbori de decizie

5 algoritmi de grupare

6 Algoritmi genetici

Domenii de aplicare

Producători de instrumente de data mining

Critica metodelor

Concluzie

Referințe

Introducere

Rezultatul dezvoltării tehnologiei informației este o cantitate colosală de date acumulate în formă electronică, în creștere într-un ritm rapid. În același timp, datele, de regulă, au o structură eterogenă (texte, imagini, audio, video, documente hipertext, baze de date relaționale). Datele acumulate pe o perioadă lungă de timp pot conține modele, tendințe și relații, care sunt informații valoroase pentru planificare, prognoză, luarea deciziilor și controlul procesului. Cu toate acestea, oamenii sunt fizic incapabili să analizeze eficient astfel de volume de date eterogene. Metodele statisticii matematice tradiționale au pretins de mult timp a fi instrumentul principal pentru analiza datelor. Cu toate acestea, ele nu permit sinteza de noi ipoteze, ci pot fi folosite doar pentru confirmarea ipotezelor preformulate și a analizei exploratorii „grund”, care formează baza prelucrării analitice online (OLAP). Adesea, formularea unei ipoteze se dovedește a fi cea mai dificilă sarcină atunci când se efectuează analize pentru luarea deciziilor ulterioare, deoarece nu toate modelele din date sunt evidente la prima vedere. Prin urmare, tehnologiile de exploatare a datelor sunt considerate una dintre cele mai importante și promițătoare subiecte pentru cercetare și aplicare în industria tehnologiei informației. Exploatarea datelor în acest caz se referă la procesul de identificare a cunoștințelor noi, corecte și potențial utile pe baza unor cantități mari de date. Astfel, MIT Technology Review a descris data mining drept una dintre cele zece tehnologii emergente care vor schimba lumea.

1. Exploatarea datelor. Concepte de bază și definiții

Data Mining este procesul de descoperire în „brută” a unor date necunoscute anterior, nebanale, practic utile și interpretabile, necesare pentru luarea deciziilor în diverse domenii ale activității umane.

Esența și scopul tehnologiei Data Mining pot fi formulate după cum urmează: este o tehnologie care este concepută pentru a căuta în volume mari de date modele neevidente, obiective și practice.

Tiparele neevidente sunt tipare care nu pot fi detectate prin metode standard de procesare a informațiilor sau prin analize de specialitate.

Tiparele obiective trebuie înțelese ca tipare care corespund pe deplin realității, spre deosebire de opinia experților, care este întotdeauna subiectivă.

Acest concept de analiză a datelor presupune că:

§ datele pot fi inexacte, incomplete (conțin omisiuni), contradictorii, eterogene, indirecte și, în același timp, să aibă volume gigantice; prin urmare, înțelegerea datelor în aplicații specifice necesită un efort intelectual semnificativ;

§ algoritmii de analiză a datelor înșiși pot avea „elemente de inteligență”, în special, capacitatea de a învăța din precedente, adică de a trage concluzii generale pe baza unor observații particulare; dezvoltarea unor astfel de algoritmi necesită, de asemenea, un efort intelectual semnificativ;

§ procesele de prelucrare a datelor brute în informație și a informațiilor în cunoștințe nu pot fi efectuate manual și necesită automatizare.

Tehnologia Data Mining se bazează pe conceptul de șabloane care reflectă fragmente de relații multidimensionale în date. Aceste modele reprezintă modele inerente subeșantioanelor de date care pot fi exprimate compact într-o formă care poate fi citită de om.

Căutarea tiparelor se efectuează folosind metode care nu sunt limitate de ipoteze a priori despre structura eșantionului și tipul de distribuție a valorilor indicatorilor analizați.

O caracteristică importantă a Data Mining-ului este natura non-standard și neevidentă a tiparelor căutate. Cu alte cuvinte, instrumentele Data Mining diferă de instrumentele de procesare a datelor statistice și instrumentele OLAP prin faptul că, în loc să verifice interdependențe asumate anterior de utilizatori, sunt capabile să găsească astfel de interdependențe în mod independent pe baza datelor disponibile și să construiască ipoteze despre natura lor. Există cinci tipuri standard de modele identificate prin metodele Data Mining:

· asociere - o mare probabilitate ca evenimentele să fie conectate între ele. Un exemplu de asociație sunt articolele dintr-un magazin care sunt adesea achiziționate împreună;

· succesiune - o mare probabilitate a unui lanț de evenimente legate în timp. Un exemplu de secvență este o situație în care, într-o anumită perioadă de la achiziționarea unui produs, altul va fi achiziționat cu un grad ridicat de probabilitate;

· clasificare - există semne care caracterizează grupul căruia îi aparține un eveniment sau un obiect;

· gruparea este un model asemănător clasificării și diferă de acesta prin faptul că grupurile în sine nu sunt specificate - sunt identificate automat în timpul prelucrării datelor;

· modele temporale - prezența modelelor în dinamica comportamentului anumitor date. Un exemplu tipic de tipar de timp sunt fluctuațiile sezoniere ale cererii pentru anumite bunuri sau servicii.

1.1 Etape în procesul de extragere a datelor

În mod tradițional, în procesul de extragere a datelor se disting următoarele etape:

1. Studiul disciplinei, în urma căruia se formulează principalele scopuri ale analizei.

2. Colectarea datelor.

Preprocesarea datelor:

o. Curățarea datelor - eliminând inconsecvențele și „zgomotul” aleatoriu din datele sursă

b. Integrarea datelor - combinarea datelor din mai multe surse posibile într-un singur depozit. Conversia datelor. În această etapă, datele sunt convertite într-o formă adecvată pentru analiză. Sunt adesea folosite agregarea datelor, eșantionarea atributelor, compresia datelor și reducerea dimensionalității.

4. Analiza datelor. Ca parte a acestei etape, algoritmii de minerit sunt utilizați pentru a extrage modele.

5. Interpretarea tiparelor găsite. Această etapă poate include vizualizarea tiparelor extrase, identificarea tiparelor cu adevărat utile bazate pe o funcție de utilitate.

Utilizarea noilor cunoștințe.

1.2 Componentele sistemelor inteligente de analiză

De obicei, sistemele de data mining au următoarele componente principale:

1. O bază de date, un depozit de date sau un alt depozit de informații. Aceasta ar putea fi una sau mai multe baze de date, depozit de date, foi de calcul sau alte tipuri de depozite care pot fi curățate și integrate.

2. Server de bază de date sau de depozit de date. Serverul specificat este responsabil pentru preluarea datelor esențiale pe baza solicitării utilizatorului.

Baza de cunoștințe. Acestea sunt cunoștințele de domeniu care ghidează cum să căutați și să evaluați utilitatea tiparelor rezultate.

Serviciul de minerit de cunoștințe. Este o parte integrantă a sistemului de data mining și conține un set de module funcționale pentru sarcini precum caracterizarea, căutarea asocierilor, clasificarea, analiza clusterului și analiza varianței.

Modul de evaluare a modelului. Această componentă calculează măsurile de interes sau utilitatea tiparelor.

Interfață grafică cu utilizatorul. Acest modul este responsabil pentru comunicarea dintre utilizator și sistemul de data mining, vizualizarea tiparelor în diferite forme.

1.3 Metode de extragere a datelor

Cele mai multe dintre metodele analitice utilizate în tehnologia Data Mining sunt algoritmi și metode matematice bine-cunoscute. Ceea ce este nou în aplicația lor este posibilitatea utilizării lor în rezolvarea anumitor probleme specifice, datorită capacităților emergente de hardware și software. Trebuie remarcat faptul că majoritatea metodelor de Data Mining au fost dezvoltate în cadrul teoriei inteligenței artificiale. Să ne uităm la cele mai utilizate metode:

Derivarea regulilor de asociere.

2. Algoritmi de rețea neuronală, ideea cărora se bazează pe o analogie cu funcționarea țesutului nervos și constă în faptul că parametrii inițiali sunt considerați ca semnale care sunt transformate în conformitate cu conexiunile existente între „neuroni”, iar raspunsul intregii retele este considerat ca raspunsul rezultat din analiza la datele originale.

Selectarea unui analog apropiat al datelor originale din datele istorice existente. Denumită și metoda „cel mai apropiat vecin”.

Arborele de decizie sunt o structură ierarhică bazată pe un set de întrebări care necesită un răspuns „Da” sau „Nu”.

Modelele de clustere sunt folosite pentru a grupa evenimente similare în grupuri pe baza valorilor similare ale mai multor câmpuri dintr-un set de date.

În capitolul următor vom descrie mai detaliat metodele de mai sus.

2. Metode de extragere a datelor

2.1 Deducerea regulilor de asociere

Regulile de asociere sunt reguli de forma „dacă... atunci...”. Căutarea unor astfel de reguli într-un set de date dezvăluie conexiuni ascunse în date aparent fără legătură. Unul dintre cele mai frecvent citate exemple de găsire a regulilor de asociere este problema găsirii de conexiuni stabile într-un coș de cumpărături. Această problemă este de a determina ce produse sunt achiziționate de clienți împreună, astfel încât agenții de marketing să poată plasa în mod corespunzător aceste produse în magazin pentru a crește vânzările.

Regulile de asociere sunt definite ca instrucțiuni de forma (X1,X2,…,Xn) -> Y, unde se presupune că Y poate fi prezent într-o tranzacție cu condiția ca X1,X2,…,Xn să fie prezent în aceeași tranzacție. Trebuie remarcat faptul că cuvântul „poate” implică faptul că regula nu este o identitate, ci este satisfăcută doar cu o anumită probabilitate. În plus, Y poate fi un set de elemente, mai degrabă decât un singur element. Probabilitatea de a găsi Y într-o tranzacție care conține elementele X1,X2,...,Xn se numește încredere. Procentul de tranzacții care conțin o regulă din numărul total de tranzacții se numește suport. Nivelul de încredere care trebuie să depășească încrederea unei reguli se numește interes.

Există diferite tipuri de reguli de asociere. În forma lor cea mai simplă, regulile de asociere comunică doar prezența sau absența unei asociații. Astfel de reguli se numesc Reguli de asociere booleene. Un exemplu de astfel de regulă: „clienții care cumpără iaurt cumpără și unt cu conținut scăzut de grăsimi”.

Regulile care grupează mai multe reguli de asociere se numesc Reguli de asociere pe mai multe niveluri sau generalizate. La construirea unor astfel de reguli, elementele sunt de obicei grupate după o ierarhie, iar căutarea se desfășoară la cel mai înalt nivel conceptual. De exemplu, „clienții care cumpără lapte cumpără și pâine”. În acest exemplu, laptele și pâinea conțin o ierarhie de diferite tipuri și mărci, dar căutarea la nivelul de jos nu va dezvălui reguli interesante.

Un tip mai complex de regulă este Regulile Cantitative de Asociere. Acest tip de regulă este căutat folosind atribute cantitative (de exemplu, preț) sau categoriale (de exemplu, gen) și este definită ca (

Tipurile de reguli de mai sus nu abordează faptul că tranzacțiile sunt, prin natura lor, dependente de timp. De exemplu, căutarea înainte ca un produs să fie listat spre vânzare sau după ce acesta a dispărut de pe piață va afecta negativ pragul de suport. Ținând cont de acest lucru, conceptul de durata de viață a atributului a fost introdus în algoritmii de căutare a regulilor de asociere temporară (Temporal Association Rules).

Problema căutării regulilor de asociere poate fi, în general, descompusă în două părți: căutarea unor seturi de elemente care apar frecvent și generarea de reguli bazate pe mulțimile care apar frecvent. Studiile anterioare au urmat, în cea mai mare parte, aceste linii și le-au extins în direcții diferite.

De la apariția algoritmului Apriori, acest algoritm este cel mai des folosit în primul pas. Multe îmbunătățiri, de exemplu în ceea ce privește viteza și scalabilitatea, vizează îmbunătățirea algoritmului Apriori, corectarea proprietății sale eronate de a genera prea mulți candidați pentru seturile de elemente care apar cel mai frecvent. Apriori generează seturi de articole folosind doar seturile mari găsite în pasul anterior, fără a reexamina tranzacțiile. Algoritmul modificat AprioriTid îmbunătățește Apriori folosind baza de date doar la prima trecere. La calcularea în pașii următori se folosesc doar datele create în prima trecere și care sunt mult mai mici ca dimensiune decât baza de date inițială. Acest lucru duce la o creștere uriașă a productivității. O versiune îmbunătățită suplimentară a algoritmului, numită AprioriHybrid, poate fi obținută prin utilizarea Apriori la primele treceri, iar apoi trecerea la AprioriTid la trecerile ulterioare, când cele de-al zecelea seturi candidate pot fi deja localizate în întregime în memoria computerului.

Eforturile ulterioare de îmbunătățire a algoritmului Apriori sunt legate de paralelizarea algoritmului (distribuția numărului, distribuția datelor, distribuția candidaților etc.), scalarea acestuia (distribuția inteligentă a datelor, distribuția hibridă), introducerea de noi structuri de date, cum ar fi arbori de elemente care apar frecvent (FP-creștere).

Al doilea pas este caracterizat în principal de autenticitate și interes. Noile modificări adaugă dimensionalitatea, calitatea și suportul de sincronizare descris mai sus regulilor tradiționale ale regulilor booleene. Un algoritm evolutiv este adesea folosit pentru a găsi reguli.

2.2 Algoritmi de rețele neuronale

Rețelele neuronale artificiale au apărut ca urmare a aplicării aparatelor matematice la studiul funcționării sistemului nervos uman cu scopul de a-l reproduce. Și anume: capacitatea sistemului nervos de a învăța și de a corecta erorile, care ar trebui să ne permită să simulăm, deși mai degrabă aproximativ, activitatea creierului uman. Principala parte structurală și funcțională a rețelei neuronale este neuronul formal, prezentat în Fig. 1, unde x0, x1,..., xn sunt componentele vectorului semnalului de intrare, w0,w1,...,wn sunt valorile greutăților semnalelor de intrare ale neuronului și y este ieșirea neuronului semnal.

Orez. 1. Neuron formal: sinapse (1), sumator (2), convertor (3).

Un neuron formal este format din 3 tipuri de elemente: sinapse, sumator și convertor. O sinapsă caracterizează puterea conexiunii dintre doi neuroni.

Adunatorul adaugă semnalele de intrare, înmulțite anterior cu greutățile corespunzătoare. Convertorul implementează funcția unui singur argument - ieșirea sumatorului. Această funcție se numește funcția de activare sau funcția de transfer a neuronului.

Neuronii formali descriși mai sus pot fi combinați în așa fel încât semnalele de ieșire ale unor neuroni să fie intrarea altora. Setul rezultat de neuroni interconectați se numește rețele neuronale artificiale (ANN) sau, pe scurt, rețele neuronale.

Există următoarele trei tipuri generale de neuroni, în funcție de poziția lor în rețeaua neuronală:

Neuroni de intrare (noduri de intrare) cărora le sunt furnizate semnale de intrare. Astfel de neuroni au de obicei o singură intrare cu greutatea unitară, nu există nicio părtinire, iar valoarea de ieșire a neuronului este egală cu semnalul de intrare;

Noduri de ieșire, ale căror valori de ieșire reprezintă semnalele de ieșire rezultate ale rețelei neuronale;

Neuroni ascunși (noduri ascunse) care nu au conexiuni directe cu semnalele de intrare, în timp ce valorile semnalelor de ieșire ale neuronilor ascunși nu sunt semnalele de ieșire ale ANN.

Pe baza structurii conexiunilor interneuronice, se disting două clase de ANN-uri:

ANN-uri feedforward, în care semnalul se propagă numai de la neuronii de intrare la neuronii de ieșire.

ANN recurent - ANN cu feedback. În astfel de ANN, semnalele pot fi transmise între orice neuroni, indiferent de locația lor în ANN.

Există două abordări generale pentru formarea unui ANN:

Antrenament cu un profesor.

Învățați fără profesor.

Învățarea supravegheată implică utilizarea unui set pre-generat de exemple de instruire. Fiecare exemplu conține un vector de semnale de intrare și un vector corespunzător de semnale de ieșire de referință, care depind de sarcina la îndemână. Acest set se numește eșantion de antrenament sau set de antrenament. Antrenarea unei rețele neuronale are ca scop modificarea greutăților conexiunilor ANN, astfel încât valorile semnalelor de ieșire ANN să difere cât mai puțin posibil de valorile necesare ale semnalelor de ieșire pentru un anumit vector de semnale de intrare. .

În învățarea nesupravegheată, ponderile conexiunii sunt ajustate fie ca urmare a competiției dintre neuroni, fie ținând cont de corelarea semnalelor de ieșire ale neuronilor între care există o conexiune. În cazul învățării nesupravegheate, nu se utilizează un set de antrenament.

Rețelele neuronale sunt folosite pentru a rezolva o gamă largă de probleme, cum ar fi planificarea sarcinilor utile pentru navetele spațiale și prognozarea ratelor de schimb. Cu toate acestea, ele nu sunt adesea utilizate în sistemele de data mining din cauza complexității modelului (cunoștințele înregistrate ca ponderea a câteva sute de conexiuni interneurale depășesc complet analiza și interpretarea umană) și timpul lung de antrenament pe un set mare de antrenament. Pe de altă parte, rețelele neuronale au astfel de avantaje pentru utilizare în sarcinile de analiză a datelor, precum rezistența la datele zgomotoase și precizia ridicată.

2.3 Metodele celui mai apropiat vecin și k-nearest neighbors

Baza algoritmului de cel mai apropiat vecin (algoritmul de cel mai apropiat vecin) și algoritmul de k-cel mai apropiat vecin (KNN) este asemănarea obiectelor. Algoritmul cel mai apropiat vecin selectează, dintre toate obiectele cunoscute, obiectul care este cât mai aproape posibil (folosind metrica distanței dintre obiecte, de exemplu, euclidian) de un nou obiect necunoscut anterior. Principala problemă cu metoda celui mai apropiat vecin este sensibilitatea acesteia la valori aberante din datele de antrenament.

Problema descrisă poate fi evitată prin algoritmul KNN, care identifică printre toate observațiile cei mai apropiați k vecini care sunt similari cu noul obiect. Pe baza claselor de vecini cei mai apropiati se ia o decizie cu privire la noul obiect. O sarcină importantă a acestui algoritm este de a selecta coeficientul k - numărul de înregistrări care vor fi considerate similare. O modificare a algoritmului în care contribuția unui vecin este proporțională cu distanța până la noul obiect (metoda celor mai apropiati vecini ponderați k) permite obținerea unei mai mari precizii de clasificare. Metoda k cei mai apropiați vecini vă permite, de asemenea, să evaluați acuratețea prognozei. De exemplu, dacă toți k vecini cei mai apropiați au aceeași clasă, atunci probabilitatea ca obiectul testat să aibă aceeași clasă este foarte mare.

Printre caracteristicile algoritmului, merită remarcată rezistența acestuia la valori aberante anormale, deoarece probabilitatea ca o astfel de înregistrare să fie inclusă în numărul de vecini k-cel mai apropiat este scăzută. Dacă s-a întâmplat acest lucru, atunci impactul asupra votului (în special ponderat) (pentru k>2) va fi, de asemenea, cel mai probabil nesemnificativ și, prin urmare, impactul asupra rezultatului clasificării va fi, de asemenea, mic. De asemenea, avantajele sunt simplitatea implementării, ușurința de interpretare a rezultatului algoritmului, capacitatea de a modifica algoritmul utilizând cele mai potrivite funcții de combinare și metrici, ceea ce vă permite să ajustați algoritmul la o anumită sarcină. Algoritmul KNN are și o serie de dezavantaje. În primul rând, setul de date utilizat pentru algoritm trebuie să fie reprezentativ. În al doilea rând, modelul nu poate fi separat de date: toate exemplele trebuie folosite pentru a clasifica un nou exemplu. Această caracteristică limitează foarte mult utilizarea algoritmului.

2.4 Arbori de decizie

Termenul „arbori de decizie” se referă la o familie de algoritmi bazată pe reprezentarea regulilor de clasificare într-o structură ierarhică, secvenţială. Aceasta este cea mai populară clasă de algoritmi pentru rezolvarea problemelor de data mining.

O familie de algoritmi pentru construirea arborilor de decizie face posibilă prezicerea valorii unui parametru pentru un caz dat pe baza unei cantități mari de date despre alte cazuri similare. De obicei, algoritmii acestei familii sunt utilizați pentru a rezolva probleme care fac posibilă împărțirea tuturor datelor inițiale în mai multe grupuri discrete.

Când se aplică algoritmi de construcție a arborelui de decizie la un set de date inițiale, rezultatul este afișat ca arbore. Astfel de algoritmi fac posibilă implementarea mai multor niveluri ale unei astfel de diviziuni, împărțind grupurile rezultate (ramuri de copac) în altele mai mici pe baza altor caracteristici. Împărțirea continuă până când valorile care se presupune a fi prezise devin aceleași (sau, în cazul unei valori continue a parametrului prezis, se închid) pentru toate grupurile rezultate (frunze ale arborelui). Aceste valori sunt folosite pentru a face predicții bazate pe acest model.

Funcționarea algoritmilor pentru construirea arborilor de decizie se bazează pe utilizarea metodelor de regresie și analiză a corelației. Unul dintre cei mai populari algoritmi ai acestei familii este CART (Classification and Regression Trees), bazat pe împărțirea datelor dintr-o ramură de arbore în două ramuri copil; Mai mult, împărțirea ulterioară a unei anumite ramuri depinde de câte date inițiale descrie această ramură. Alți algoritmi similari vă permit să împărțiți o ramură în mai multe ramuri copil. În acest caz, împărțirea se face pe baza celui mai mare coeficient de corelație pentru datele descrise de ramura între parametrul conform căruia are loc împărțirea și parametrul care trebuie prezis ulterior.

Popularitatea abordării este asociată cu claritatea și claritatea. Dar arborii de decizie sunt în mod fundamental incapabili să găsească „cele mai bune” (cele mai complete și mai precise) reguli în date. Ei implementează principiul naiv al vizualizării secvențiale a caracteristicilor și găsesc de fapt părți ale tiparelor reale, creând doar iluzia unei concluzii logice.

2.5 Algoritmi de grupare

Clustering este sarcina de a împărți un set de obiecte în grupuri numite clustere. Principala diferență între grupare și clasificare este că lista de grupuri nu este clar definită și este determinată în timpul funcționării algoritmului.

Aplicarea analizei cluster în general se reduce la următorii pași:

· selectarea unui eșantion de obiecte pentru grupare;

· definirea unui set de variabile prin care vor fi evaluate obiectele din eșantion. Dacă este necesar, normalizați valorile variabilelor;

· calcularea valorilor de măsurare a similitudinii dintre obiecte;

· aplicarea metodei de analiză a clusterelor pentru a crea grupuri de obiecte similare (clustere);

· prezentarea rezultatelor analizei.

După primirea și analizarea rezultatelor, este posibil să se ajusteze metrica selectată și metoda de grupare până la obținerea rezultatului optim.

Algoritmii de grupare includ grupuri ierarhice și plate. Algoritmii ierarhici (numiți și algoritmi de taxonomie) construiesc nu doar o partiție a eșantionului în clustere disjunse, ci un sistem de partiții imbricate. Astfel, rezultatul algoritmului este un arbore de clustere, a cărui rădăcină este întregul eșantion, iar frunzele sunt cele mai mici clustere. Algoritmii plati construiesc o partiție de obiecte în grupuri care nu se intersectează unele cu altele.

O altă clasificare a algoritmilor de grupare este în algoritmi clari și neclari. Algoritmi clari (sau care nu se suprapun) atribuie fiecărui obiect eșantion un număr de cluster, adică fiecare obiect aparține unui singur cluster. Algoritmii fuzzy (sau care se intersectează) atribuie fiecărui obiect un set de valori reale care arată gradul de relație a obiectului cu clusterele. Astfel, fiecare obiect aparține fiecărui grup cu o anumită probabilitate.

Printre algoritmii de grupare ierarhică, există două tipuri principale: algoritmi de jos în sus și de sus în jos. Algoritmii de sus în jos funcționează pe un principiu de sus în jos: mai întâi, toate obiectele sunt plasate într-un singur grup, care este apoi împărțit în grupuri din ce în ce mai mici. Mai obișnuiți sunt algoritmii de jos în sus care încep prin plasarea fiecărui obiect într-un grup separat și apoi combinând grupurile în altele din ce în ce mai mari până când toate obiectele din eșantion sunt conținute într-un singur grup. Astfel, se construiește un sistem de partiții imbricate. Rezultatele unor astfel de algoritmi sunt de obicei prezentate sub forma unui arbore.

Un dezavantaj al algoritmilor ierarhici este sistemul de partiții complete, care poate fi inutil în contextul problemei care se rezolvă.

Să luăm acum în considerare algoritmii plati. Cei mai simpli dintre această clasă sunt algoritmii de eroare pătratică. Problema grupării pentru acești algoritmi poate fi considerată ca construirea unei partiții optime a obiectelor în grupuri. În acest caz, optimitatea poate fi definită ca cerința de a minimiza eroarea pătratică medie a partiționării:

,

,

Unde c j - „centrul de masă” al clusterului j(punct cu caracteristici medii pentru un cluster dat).

Cel mai comun algoritm din această categorie este metoda k-means. Acest algoritm construiește un număr dat de clustere situate cât mai departe posibil. Lucrarea algoritmului este împărțită în mai multe etape:

Selectați aleatoriu k puncte care sunt „centrele de masă” inițiale ale clusterelor.

2. Atribuiți fiecare obiect grupului cu cel mai apropiat „centru de masă”.

Dacă criteriul de oprire a algoritmului nu este satisfăcut, reveniți la pasul 2.

Modificarea minimă a erorii pătratice medii este de obicei aleasă ca criteriu pentru oprirea algoritmului. De asemenea, este posibil să opriți algoritmul dacă la pasul 2 nu au existat obiecte care s-au mutat de la un cluster la altul. Dezavantajele acestui algoritm includ necesitatea de a specifica numărul de clustere pentru partiționare.

Cel mai popular algoritm de grupare fuzzy este algoritmul c-means. Este o modificare a metodei k-means. Etapele algoritmului:

1. Selectați partiția fuzzy inițială n obiecte pe k clustere prin alegerea unei matrice de membri U dimensiune n x k.

2. Folosind matricea U, găsiți valoarea criteriului de eroare fuzzy:

,

,

Unde c k - „centrul de masă” al clusterului fuzzy k:

3. Regrupați obiectele pentru a reduce această valoare a criteriului de eroare neclară.

4. Reveniți la pasul 2 până când matricea se schimbă U nu va deveni nesemnificativ.

Acest algoritm poate să nu fie potrivit dacă numărul de clustere este necunoscut în prealabil sau dacă este necesar să se atribuie fără ambiguitate fiecare obiect unui cluster.

Următorul grup de algoritmi sunt algoritmi bazați pe teoria grafurilor. Esența unor astfel de algoritmi este că o selecție de obiecte este reprezentată sub forma unui grafic G=(V, E), ale căror vârfuri corespund obiectelor și ale căror margini au o pondere egală cu „distanța” dintre obiecte. Avantajele algoritmilor de grupare grafică sunt claritatea, ușurința relativă de implementare și capacitatea de a introduce diverse îmbunătățiri bazate pe considerații geometrice. Algoritmii principali sunt algoritmul pentru identificarea componentelor conectate, algoritmul pentru construirea unui arbore de acoperire minim și algoritmul de clustering strat cu strat.

Pentru a selecta un parametru R De obicei, se construiește o histogramă de distribuții ale distanțelor pe perechi. În sarcinile cu o structură de cluster de date bine definită, histograma va avea două vârfuri - unul corespunde distanțelor intra-cluster, al doilea - distanțe inter-cluster. Parametru R este selectat din zona minimă dintre aceste vârfuri. În același timp, este destul de dificil să controlezi numărul de clustere folosind un prag de distanță.

Algoritmul arborelui de întindere minimă construiește mai întâi un arbore de întindere minim pe un grafic și apoi elimină secvențial muchiile cu cea mai mare greutate. Algoritmul de grupare strat cu strat se bazează pe identificarea componentelor grafice conectate la un anumit nivel de distanțe între obiecte (vârfurile). Nivelul distanței este stabilit de pragul distanței c. De exemplu, dacă distanța dintre obiecte este , atunci .

Algoritmul de grupare strat cu strat generează o secvență de subgrafe ale graficului G, care reflectă relațiile ierarhice dintre clustere:

![]() ,

,

Unde G t = (V, E t )

- graficul nivelului Cu t, ![]() ,

,

Cu t - al-lea prag de distanță, m - numărul de niveluri ierarhice,

G 0 = (V, o), o este setul gol de muchii ale graficului obținut de t 0 = 1,

G m = G, adică un grafic al obiectelor fără restricții de distanță (lungimea marginilor graficului), deoarece t m = 1.

Prin modificarea pragurilor de distanță ( Cu 0 , …, Cu m), unde 0 = Cu 0 < Cu 1 < …< Cu m = 1, este posibil să se controleze adâncimea ierarhiei clusterelor rezultate. Astfel, algoritmul de grupare strat cu strat este capabil să creeze atât o partiție plată, cât și ierarhică a datelor.

Clustering vă permite să atingeți următoarele obiective:

· îmbunătățește înțelegerea datelor prin identificarea grupurilor structurale. Împărțirea eșantionului în grupuri de obiecte similare face posibilă simplificarea ulterioară a procesării datelor și luării deciziilor prin aplicarea unei metode de analiză diferite pentru fiecare cluster;

· vă permite să stocați în mod compact datele. Pentru a face acest lucru, în loc să stocați întregul eșantion, puteți păstra o observație tipică din fiecare grup;

· detectarea de noi obiecte atipice care nu au căzut în niciun cluster.

De obicei, gruparea este utilizată ca metodă auxiliară în analiza datelor.

2.6 Algoritmi genetici

Algoritmii genetici se numără printre metodele universale de optimizare care permit rezolvarea unor probleme de diferite tipuri (combinatorii, probleme generale cu și fără restricții) și cu grade variate de complexitate. În același timp, algoritmii genetici se caracterizează prin posibilitatea căutării atât cu un singur criteriu, cât și cu mai multe criterii într-un spațiu mare, al cărui peisaj nu este neted.

Acest grup de metode utilizează un proces iterativ de evoluție a unei secvențe de generații de modele, inclusiv operațiile de selecție, mutație și încrucișare. La începutul algoritmului, populația se formează aleatoriu. Pentru a evalua calitatea soluțiilor codificate, se utilizează funcția de fitness, care este necesară pentru a calcula fitness-ul fiecărui individ. Pe baza rezultatelor evaluării indivizilor, cei mai potriviți dintre ei sunt selectați pentru încrucișare. Ca urmare a încrucișării indivizilor selectați prin aplicarea operatorului de încrucișare genetică, se creează descendenți, a căror informație genetică se formează ca urmare a schimbului de informații cromozomiale între indivizii părinte. Descendenții creați formează o nouă populație, iar unii dintre descendenți mută, ceea ce se exprimă într-o schimbare aleatorie a genotipurilor lor. Etapa, inclusiv secvența „Evaluarea populației” - „Selectare” - „Încrucișare” - „Mutație”, se numește generație. Evoluția unei populații constă într-o succesiune de astfel de generații.

Se disting următorii algoritmi de selectare a persoanelor pentru încrucișare:

· Panmixia. Ambii indivizi care vor forma o pereche parentală sunt selectați aleatoriu din întreaga populație. Orice individ poate deveni membru al mai multor perechi. Această abordare este universală, dar eficiența algoritmului scade odată cu creșterea dimensiunii populației.

· Selectie. Părinții pot fi persoane cu o condiție fizică cel puțin medie. Această abordare asigură o convergență mai rapidă a algoritmului.

· Consangvinizare. Metoda se bazează pe formarea unei perechi bazată pe rudenia apropiată. Aici, relația este înțeleasă ca distanța dintre membrii unei populații, atât în sensul distanței geometrice a indivizilor în spațiul parametrilor, cât și al distanței Heming dintre genotipuri. Prin urmare, se face o distincție între consangvinizarea genotipică și cea fenotipică. Primul membru al perechii care trebuie încrucișat este selectat la întâmplare, iar cel de-al doilea este mai probabil să fie individul cel mai apropiat de acesta. Consangvinizarea poate fi caracterizată prin proprietatea de a concentra căutarea în nodurile locale, ceea ce duce de fapt la împărțirea populației în grupuri locale separate în jurul unor zone ale peisajului care sunt suspecte pentru extreme.

· Outbreeding. Formarea unei perechi pe baza rudeniei îndepărtate, pentru indivizii cei mai îndepărtați. Outbreeding urmărește să împiedice algoritmul să convergă spre soluții deja găsite, forțând algoritmul să se uite la zone noi, neexplorate.

Algoritmi pentru formarea unei noi populații:

· Selectie cu deplasare. Dintre toți indivizii cu aceleași genotipuri, se acordă preferință celor a căror fitness este mai mare. Astfel, sunt atinse două obiective: cele mai bune soluții găsite, care au seturi de cromozomi diferite, nu se pierd, iar în populație se menține constant o diversitate genetică suficientă. Deplasarea formează o nouă populație de indivizi localizați la distanță, în locul indivizilor grupați în jurul soluției actuale găsite. Această metodă este utilizată pentru probleme multiextremale.

· Selecție de elită. Metodele de selecție de elită asigură că selecția va asigura supraviețuirea celor mai buni membri ai populației. În același timp, unii dintre cei mai buni indivizi trec generației următoare fără nicio schimbare. Convergența rapidă oferită de selecția de elită poate fi compensată printr-o metodă adecvată de selectare a perechilor de părinți. În acest caz, deseori este folosită îndoirea. Această combinație de „selecție de elită” este una dintre cele mai eficiente.

· Selectarea turneelor. Selecția turneelor implementează n turnee pentru a selecta n persoane. Fiecare turneu este construit pe selectarea a k elemente din populație și selectarea celui mai bun individ dintre ele. Cea mai comună este selecția turneelor cu k = 2.

Una dintre cele mai populare aplicații ale algoritmilor genetici în domeniul Data Mining este căutarea celui mai optim model (căutarea unui algoritm care să corespundă specificului unui anumit domeniu). Algoritmii genetici sunt utilizați în primul rând pentru a optimiza topologia rețelelor neuronale și a greutăților. Cu toate acestea, ele pot fi folosite și ca instrument independent.

3. Aplicații

Tehnologia Data Mining are o gamă cu adevărat largă de aplicații, fiind, de fapt, un set de instrumente universale pentru analiza datelor de orice tip.

Marketing

Unul dintre primele domenii în care au fost aplicate tehnologiile de data mining a fost domeniul marketingului. Sarcina cu care a început dezvoltarea metodelor de Data Mining se numește analiza coșului de cumpărături.

Această sarcină este de a identifica produsele pe care cumpărătorii tind să le cumpere împreună. Cunoașterea coșului de cumpărături este necesară pentru desfășurarea campaniilor publicitare, formarea de recomandări personale către clienți, elaborarea unei strategii de creare a stocurilor de mărfuri și modalități de aranjare a acestora în zonele de vânzare.

Marketingul rezolvă, de asemenea, probleme precum determinarea publicului țintă al unui anumit produs pentru promovarea sa de succes; Cercetare temporală a modelelor care ajută companiile să ia decizii privind inventarul; crearea de modele predictive, care să permită întreprinderilor să recunoască natura nevoilor diverselor categorii de clienți cu un anumit comportament; prezicerea fidelității clienților, care vă permite să identificați din timp momentul plecării clientului atunci când analizați comportamentul acestuia și, eventual, să preveniți pierderea unui client valoros.

Industrie

Unul dintre domeniile importante în acest domeniu este monitorizarea și controlul calității, unde, folosind instrumente de analiză, este posibil să se prezică defecțiunile echipamentelor, apariția defecțiunilor și să se planifice lucrările de reparații. Prognoza popularității anumitor caracteristici și cunoașterea caracteristicilor care sunt de obicei comandate împreună ajută la optimizarea producției și la concentrarea acesteia pe nevoile reale ale consumatorilor.

Medicament

În medicină, analiza datelor este, de asemenea, folosită cu destul de mult succes. Exemple de sarcini includ analiza rezultatelor examinărilor, diagnosticarea, compararea eficacității metodelor de tratament și a medicamentelor, analiza bolilor și răspândirea lor și identificarea efectelor secundare. Tehnologiile Data Mining, cum ar fi regulile de asociere și modelele secvențiale, au fost utilizate cu succes pentru a identifica conexiunile dintre medicamente și efectele secundare.

Genetica moleculară și inginerie genetică

Poate cea mai acută și în același timp clară sarcină de descoperire a tiparelor în datele experimentale este în genetica moleculară și ingineria genetică. Aici este formulat ca o definiție a markerilor, care sunt înțeleși ca coduri genetice care controlează anumite caracteristici fenotipice ale unui organism viu. Astfel de coduri pot conține sute, mii sau mai multe elemente înrudite. Rezultatul analizei datelor analitice este, de asemenea, relația descoperită de oamenii de știință genetician între modificările secvenței ADN-ului uman și riscul de a dezvolta diferite boli.

Chimie aplicată

Metodele Data Mining sunt folosite și în domeniul chimiei aplicate. Aici se pune adesea problema clarificării caracteristicilor structurii chimice a anumitor compuși care determină proprietățile acestora. Această sarcină este deosebit de relevantă atunci când se analizează compuși chimici complecși, a căror descriere include sute și mii de elemente structurale și conexiunile lor.

Combaterea crimei

Instrumentele de data mining au fost folosite relativ recent în domeniul securității, dar au fost deja obținute rezultate practice care confirmă eficiența extragerii de date în acest domeniu. Oamenii de știință elvețieni au dezvoltat un sistem de analiză a activității de protest pentru a prezice incidente viitoare și un sistem de urmărire a amenințărilor cibernetice emergente și a acțiunilor hackerilor din lume. Ultimul sistem vă permite să preziceți amenințările cibernetice și alte riscuri de securitate a informațiilor. Metodele Data Mining sunt, de asemenea, folosite cu succes pentru a detecta frauda cu cardul de credit. Analizând tranzacțiile anterioare care ulterior s-au dovedit a fi frauduloase, banca identifică unele modele de astfel de fraude.

Alte aplicații

· Analiza riscurilor. De exemplu, prin identificarea combinațiilor de factori asociați cu daunele plătite, asigurătorii își pot reduce pierderile din răspundere. Există un caz cunoscut în care o mare companie de asigurări din Statele Unite a descoperit că sumele plătite pentru daunele persoanelor căsătorite erau de două ori mai mari decât sumele plătite pentru daune de către persoanele singure. Compania a răspuns la aceste noi cunoștințe prin revizuirea politicii sale generale de a oferi reduceri clienților de familie.

· Meteorologie. Sunt utilizate predicții meteo folosind metode de rețele neuronale, în special hărți Kohonen auto-organizate.

· Politica de personal. Instrumentele de analiză ajută serviciile de HR să selecteze cei mai de succes candidați pe baza analizei datelor din CV-urile lor și să modeleze caracteristicile angajaților ideali pentru o anumită poziție.

4. Producătorii de instrumente de Data Mining

Instrumentele de extragere a datelor sunt în mod tradițional produse software costisitoare. Prin urmare, până de curând, principalii consumatori ai acestei tehnologii erau băncile, companiile financiare și de asigurări, marile întreprinderi comerciale, iar principalele sarcini care necesită utilizarea Data Mining-ului erau considerate a fi evaluarea riscurilor de credit și de asigurare și dezvoltarea politicilor de marketing. , planuri tarifare și alte principii de lucru cu clienții. În ultimii ani, situația a suferit anumite schimbări: pe piața de software au apărut instrumente de Data Mining relativ ieftine și chiar sisteme distribuite liber, ceea ce a făcut această tehnologie accesibilă întreprinderilor mici și mijlocii.

Printre instrumentele plătite și sistemele de analiză a datelor, liderii sunt SAS Institute (SAS Enterprise Miner), SPSS (SPSS, Clementine) și StatSoft (STATISTICA Data Miner). Soluțiile destul de cunoscute sunt de la Angoss (Angoss KnowledgeSTUDIO), IBM (IBM SPSS Modeler), Microsoft (Microsoft Analysis Services) și (Oracle) Oracle Data Mining.

Alegerea software-ului liber este, de asemenea, variată. Există atât instrumente universale de analiză, cum ar fi JHepWork, KNIME, Orange, RapidMiner, cât și instrumente specializate, de exemplu, Carrot2 - un cadru pentru gruparea datelor de text și rezultatele interogărilor de căutare, Chemicalize.org - o soluție în domeniul chimiei aplicate, Instrument de procesare a limbajului natural NLTK (Natural Language Toolkit).

5. Critica metodelor

Rezultatele Data Mining depind în mare măsură de nivelul de pregătire a datelor și nu de „capacitățile minunate” ale unor algoritmi sau set de algoritmi. Aproximativ 75% din munca în Data Mining constă în colectarea datelor, care are loc înainte ca instrumentele de analiză să fie aplicate. Utilizarea analfabetă a instrumentelor va duce la o risipă a potențialului companiei și, uneori, la milioane de dolari.

Opinia lui Herb Edelstein, un expert de renume mondial în domeniul Data Mining, Data Warehousing și CRM: „Un studiu recent realizat de Two Crows a arătat că Data Mining este încă în stadiile incipiente de dezvoltare. Multe organizații sunt interesate de această tehnologie, dar doar câteva implementează în mod activ astfel de proiecte. Am putut afla un alt punct important: procesul de implementare a Data Mining în practică se dovedește a fi mai complex decât se aștepta. Se presupune că este suficient să rulați un astfel de instrument pe o bază de date terabyte, iar informații utile vor apărea instantaneu. De fapt, un proiect de Data Mining de succes necesită o înțelegere a activității, cunoașterea datelor și instrumentelor și a procesului de analiză a datelor.” Astfel, înainte de a utiliza tehnologia Data Mining, este necesar să se analizeze cu atenție limitările impuse de metode și problemele critice asociate cu aceasta, precum și să se evalueze sobru capacitățile tehnologiei. Problemele critice includ următoarele:

1. Tehnologia nu poate oferi răspunsuri la întrebările care nu au fost puse. Nu poate înlocui analistul, ci îi oferă doar un instrument puternic pentru a-și facilita și îmbunătăți munca.

2. Complexitatea dezvoltării și exploatării unei aplicații Data Mining.

Întrucât această tehnologie este un domeniu multidisciplinar, pentru a dezvolta o aplicație care să includă Data Mining, este necesar să se implice specialiști din diferite domenii, precum și să se asigure interacțiunea lor de înaltă calitate.

3. Calificările utilizatorului.

Diferite instrumente de Data Mining au grade diferite de ușurință în utilizare a interfeței și necesită anumite calificări ale utilizatorului. Prin urmare, software-ul trebuie să se potrivească cu nivelul de calificare al utilizatorului. Utilizarea Data Mining ar trebui să fie indisolubil legată de îmbunătățirea calificărilor utilizatorului. Cu toate acestea, în prezent există puțini specialiști în Data Mining care sunt bine versați în procesele de afaceri.

4. Extragerea de informații utile este imposibilă fără o bună înțelegere a esenței datelor.

Sunt necesare selecția atentă a modelului și interpretarea dependențelor sau tiparelor care sunt descoperite. Prin urmare, lucrul cu astfel de instrumente necesită o colaborare strânsă între un expert în domeniu și un specialist în instrumente de Data Mining. Modelele persistente trebuie integrate inteligent în procesele de afaceri pentru a permite modelelor să fie evaluate și actualizate. Recent, sistemele Data Mining sunt furnizate ca parte a tehnologiei de depozitare a datelor.

5. Dificultate în pregătirea datelor.

O analiză de succes necesită preprocesare de înaltă calitate a datelor. Potrivit analiștilor și utilizatorilor bazei de date, procesul de preprocesare poate dura până la 80% din întregul proces de Data Mining.

Astfel, pentru ca tehnologia să funcționeze de la sine, va necesita mult efort și timp, care intră în analiza preliminară a datelor, selecția modelului și ajustarea acestuia.

6. Un procent mare de rezultate false, nesigure sau inutile.

Folosind tehnologiile Data Mining, puteți găsi informații cu adevărat foarte valoroase, care pot oferi un avantaj semnificativ în planificarea, managementul și luarea deciziilor ulterioare. Cu toate acestea, rezultatele obținute folosind metodele Data Mining conțin destul de des concluzii false și lipsite de sens. Mulți experți susțin că instrumentele Data Mining pot produce un număr mare de rezultate nesigure din punct de vedere statistic. Pentru a reduce procentul de astfel de rezultate, este necesar să se verifice adecvarea modelelor obținute pe datele de testare. Cu toate acestea, este imposibil să evitați complet concluziile false.

7. Cost ridicat.

Un produs software de înaltă calitate este rezultatul unui efort semnificativ din partea dezvoltatorului. Prin urmare, software-ul Data Mining este în mod tradițional un produs software scump.

8. Disponibilitatea unor date reprezentative suficiente.

Instrumentele Data Mining, spre deosebire de cele statistice, teoretic nu necesită o cantitate strict definită de date istorice. Această caracteristică poate determina detectarea modelelor nesigure, false și, ca urmare, luarea unor decizii incorecte pe baza acestora. Este necesar să se monitorizeze semnificația statistică a cunoștințelor descoperite.

algoritmul rețelei neuronale de grupare a minării de date

Concluzie

Este făcută o scurtă descriere a domeniilor de aplicare și sunt prezentate critici la adresa tehnologiei Data Mining și opiniile experților în acest domeniu.

Listăliteratură

1. Han și Micheline Kamber. Miningul de date: concepte și tehnici. Ediția a II-a. - Universitatea din Illinois la Urbana-Champaign

Berry, Michael J. A. Tehnici de extragere a datelor: pentru marketing, vânzări și managementul relațiilor cu clienții - Ed. a II-a.

Siu Nin Lam. Descoperirea regulilor de asociere în data mining. - Departamentul de Informatică Universitatea Illinois din Urbana-Champaign

Dezvoltarea metodelor de înregistrare și stocare a datelor a dus la o creștere rapidă a volumului de informații colectate și analizate. Volumele de date sunt atât de impresionante încât este pur și simplu imposibil ca o persoană să le analizeze singură, deși necesitatea unei astfel de analize este destul de evidentă, deoarece aceste date „brute” conțin cunoștințe care pot fi folosite în luarea deciziilor. Pentru a efectua analiza automată a datelor, se utilizează Data Mining.

Data Mining este procesul de descoperire în „brută” a unor date necunoscute anterior, nebanale, practic utile și interpretabile, necesare pentru luarea deciziilor în diverse domenii ale activității umane. Data Mining este unul dintre pașii descoperirii cunoștințelor în baze de date.

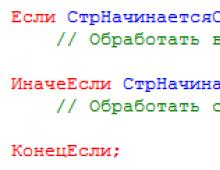

Informațiile găsite în procesul de aplicare a metodelor Data Mining nu trebuie să fie banale și necunoscute anterior, de exemplu, vânzările medii nu sunt. Cunoștințele ar trebui să descrie noi conexiuni între proprietăți, să prezică valorile unor caracteristici pe baza altora etc. Cunoștințele găsite trebuie să fie aplicabile unor date noi cu un anumit grad de fiabilitate. Utilitatea constă în faptul că aceste cunoștințe pot aduce anumite beneficii atunci când sunt aplicate. Cunoștințele trebuie să fie într-o formă nematematică, care să fie înțeleasă de utilizator. De exemplu, construcțiile logice „dacă... atunci...” sunt cel mai ușor percepute de oameni. Mai mult, astfel de reguli pot fi folosite în diferite SGBD-uri ca interogări SQL. În cazul în care cunoștințele extrase nu sunt transparente pentru utilizator, trebuie să existe metode de post-procesare pentru a le aduce într-o formă interpretabilă.

Algoritmii utilizați în Data Mining necesită o mulțime de calcule. Anterior, acesta a fost un factor limitativ pentru utilizarea practică pe scară largă a Data Mining, dar creșterea de astăzi a performanței procesoarelor moderne a atenuat gravitatea acestei probleme. Acum, într-un timp rezonabil, puteți efectua o analiză de înaltă calitate a sute de mii și milioane de înregistrări.

Probleme rezolvate prin metodele Data Mining:

- Clasificare– aceasta este atribuirea obiectelor (observații, evenimente) uneia dintre clasele cunoscute anterior.

- Regresia, inclusiv sarcinile de prognoză. Stabilirea dependenței ieșirilor continue de variabilele de intrare.

- Clustering este o grupare de obiecte (observații, evenimente) bazată pe date (proprietăți) care descriu esența acestor obiecte. Obiectele dintr-un cluster trebuie să fie „asemănătoare” între ele și diferite de obiectele incluse în alte clustere. Cu cât obiectele dintr-un cluster sunt mai asemănătoare și cu cât sunt mai multe diferențe între clustere, cu atât este mai precisă gruparea.

- Asociere– identificarea tiparelor între evenimentele înrudite. Un exemplu de astfel de model este o regulă care indică faptul că evenimentul X decurge din evenimentul Y. Astfel de reguli sunt numite asociative. Această problemă a fost propusă mai întâi pentru a găsi modele tipice de cumpărături în supermarketuri, așa că uneori este numită și analiza coșului de piață.

- Modele secvențiale– stabilirea tiparelor între evenimente legate în timp, i.e. detectarea dependenței că dacă apare evenimentul X, atunci după un anumit timp se va produce evenimentul Y.

- Analiza abaterilor– identificarea celor mai necaracteristice tipare.

Problemele de analiză a afacerii sunt formulate diferit, dar soluția pentru cele mai multe dintre ele se rezumă la una sau alta problemă de Data Mining sau o combinație a acestora. De exemplu, evaluarea riscului este o soluție la o problemă de regresie sau clasificare, segmentarea pieței este gruparea, stimularea cererii este reguli de asociere. De fapt, sarcinile Data Mining sunt elementele din care poate fi asamblată o soluție la marea majoritate a problemelor reale de afaceri.

Pentru a rezolva problemele de mai sus, se folosesc diverse metode și algoritmi de Data Mining. Datorită faptului că Data Mining s-a dezvoltat și se dezvoltă la intersecția unor discipline precum statistica, teoria informației, învățarea automată și teoria bazelor de date, este destul de firesc ca majoritatea algoritmilor și metodelor de Data Mining să fie dezvoltate pe baza diferitelor metode din acestea. discipline. De exemplu, procedura de grupare k-means a fost pur și simplu împrumutată din statistici. Următoarele metode de Data Mining au devenit foarte populare: rețele neuronale, arbori de decizie, algoritmi de clustering, inclusiv cei scalabili, algoritmi de detectare a conexiunilor asociative între evenimente etc.

Deductor este o platformă analitică care include un set complet de instrumente pentru rezolvarea problemelor de Data Mining: regresie liniară, rețele neuronale supravegheate, rețele neuronale nesupravegheate, arbori de decizie, căutarea regulilor de asociere și multe altele. Pentru multe mecanisme, sunt furnizate vizualizatoare specializate, care facilitează foarte mult utilizarea modelului rezultat și interpretarea rezultatelor. Puterea platformei nu este doar implementarea algoritmilor moderni de analiză, ci și capacitatea de a combina în mod arbitrar diverse mecanisme de analiză.

Instrumente de extragere a datelor

În prezent, tehnologia Data Mining este reprezentată de o serie de produse software comerciale și distribuite gratuit. O listă destul de completă și actualizată în mod regulat a acestor produse poate fi găsită pe site www. kdnuggets. com, dedicat minării de date. Produsele software Data Mining pot fi clasificate după aceleași principii care stau la baza clasificării tehnologiei în sine. Cu toate acestea, o astfel de clasificare nu va avea nicio valoare practică. Datorită concurenței ridicate pe piață și a dorinței de soluții tehnice complete, multe dintre produsele Data Mining acoperă literalmente toate aspectele aplicării tehnologiilor analitice. Prin urmare, este mai logic să clasificăm produsele Data Mining în funcție de modul în care sunt implementate și, în consecință, de ce potențial de integrare oferă. Evident, aceasta este și o convenție, deoarece un astfel de criteriu nu ne permite să conturăm granițe clare între produse. Cu toate acestea, o astfel de clasificare are un avantaj indubitabil. Vă permite să luați rapid o decizie cu privire la alegerea uneia sau a altei soluții gata făcute atunci când inițializați proiecte în domeniul analizei datelor, dezvoltării sistemelor de suport decizional, creării de depozite de date etc.

Deci, produsele Data Mining pot fi împărțite în trei mari categorii:

incluse ca parte integrantă în sistemele de management al bazelor de date;

biblioteci de algoritmi Data Mining cu infrastructura însoțitoare;

soluții în cutie sau desktop („cutii negre”).

Produsele din primele două categorii oferă cele mai mari oportunități de integrare și vă permit să realizați potențialul analitic în aproape orice aplicație din orice domeniu. Aplicațiile în cutie, la rândul lor, pot oferi unele progrese unice în domeniul Data Mining-ului sau pot fi specializate pentru o anumită aplicație. Cu toate acestea, în majoritatea cazurilor, acestea sunt problematice pentru a fi integrate în soluții mai largi.

Includerea capacităților analitice în sistemele comerciale de gestionare a bazelor de date este o tendință naturală cu un potențial enorm. Într-adevăr, unde, dacă nu în locurile în care sunt concentrate datele, are cel mai logic să plasăm mijloacele de prelucrare a acestora? Pe baza acestui principiu, funcționalitatea Data Mining este implementată în prezent în următoarele baze de date comerciale:

Microsoft SQL Server;

Puncte principale

Data mining vă permite să generați automat, pe baza unei cantități mari de date acumulate, ipoteze care pot fi verificate de alte instrumente de analiză (de exemplu, OLAP).

Miningul de date este cercetarea și descoperirea de către o mașină (algoritmi, instrumente de inteligență artificială) a cunoștințelor ascunse în date brute care anterior erau necunoscute, netriviale, practic utile și accesibile interpretării umane.

Metodele Data Mining rezolvă trei probleme principale: problema clasificării și regresiei, problema căutării regulilor de asociere și problema grupării. În funcție de scopul lor, ele sunt împărțite în descriptive și predictive.

Pe baza metodelor de rezolvare a problemelor, acestea se împart în învățare supravegheată (învățare cu profesor) și învățare nesupravegheată (învățare fără profesor).

Sarcina clasificării și regresiei se rezumă la determinarea valorii variabilei dependente a unui obiect din variabilele sale independente. Dacă variabila dependentă ia valori numerice, atunci vorbim despre o problemă de regresie, în caz contrar - despre o problemă de clasificare.

Când căutați reguli de asociere, scopul este de a găsi dependențe (sau asocieri) frecvente între obiecte sau evenimente. Dependențele găsite sunt prezentate sub formă de reguli și pot fi folosite atât pentru a înțelege mai bine natura datelor analizate, cât și pentru a prezice evenimente.

Sarcina grupării este de a căuta grupuri independente (clustere) și caracteristicile acestora în întregul set de date analizate. Rezolvarea acestei probleme vă ajută să înțelegeți mai bine datele.

În plus, gruparea obiectelor omogene face posibilă reducerea numărului acestora și, prin urmare, facilitarea analizei.

Metodele Data Mining se află la intersecția diferitelor domenii ale tehnologiei informației: statistici, rețele neuronale, seturi fuzzy, algoritmi genetici etc.

Analiza inteligentă include următoarele etape: înțelegerea și formularea problemei de analiză, pregătirea datelor pentru analiza automată, aplicarea metodelor Data Mining și construirea modelelor, verificarea modelelor construite și interpretarea modelelor de către oameni.

Înainte de a aplica tehnicile de Data Mining, datele sursă trebuie transformate.

Analiza informațiilor structurate stocate în baze de date necesită o prelucrare prealabilă: proiectarea unei baze de date, introducerea informațiilor după anumite reguli, plasarea acesteia în structuri speciale (de exemplu, tabele relaționale), etc. Astfel, direct pentru analiza acestor informații și obținerea de noi cunoștințe din aceasta. necesită un efort suplimentar. Cu toate acestea, ele nu sunt întotdeauna legate de analiză și nu conduc neapărat la rezultatul dorit. Din această cauză, eficiența analizei informațiilor structurate scade. În plus, nu toate tipurile de date pot fi structurate fără a pierde informații utile. De exemplu, este aproape imposibil să convertiți documente text într-o reprezentare tabelară fără a pierde semantica textului și a relațiilor dintre entități. Din acest motiv, astfel de documente sunt stocate în baza de date fără transformare, precum câmpurile de text (câmpurile BLOB). În același timp, în text este ascunsă o cantitate imensă de informații, dar natura sa nestructurată nu permite utilizarea algoritmilor de Data Mining. Metodele de analiză a textului nestructurat rezolvă această problemă. În literatura occidentală, o astfel de analiză se numește Text Mining.

Metodele de analiză în textele nestructurate se află la intersecția mai multor domenii: Miningul de date, procesarea limbajului natural, regăsirea informațiilor, extragerea informațiilor și managementul cunoștințelor.

Definiția text Mining: Descoperirea cunoștințelor de text este procesul non-trivial de descoperire a unor modele cu adevărat noi, potențial utile și ușor de înțeles în datele text nestructurate.

După cum puteți vedea, diferă de definiția Data Mining doar prin noul concept de „date text nestructurate”. O astfel de cunoaștere este înțeleasă ca un set de documente care reprezintă un text unificat din punct de vedere logic, fără nicio restricție asupra structurii acestuia. Exemple de astfel de documente sunt: pagini web, e-mail, documente de reglementare etc. În general, astfel de documente pot fi complexe și mari și includ nu numai text, ci și informații grafice. Documentele care utilizează XML (Extensible Markup Language), SGML (Standard Generalized Markup Language) și alte convenții similare cu structura textului sunt numite documente semi-structurate. Ele pot fi, de asemenea, procesate folosind metodele Text Mining.

Procesul de analiză a documentelor text poate fi reprezentat ca o succesiune de mai multe etape

Căutați informații. Primul pas este identificarea documentelor care trebuie analizate și asigurarea disponibilității acestora. De regulă, utilizatorii pot determina setul de documente care urmează să fie analizate independent - manual, dar cu un număr mare de documente este necesar să se utilizeze opțiuni de selecție automată conform criteriilor specificate.

Prelucrarea documentelor. La acest pas, se efectuează transformări simple, dar necesare asupra documentelor pentru a le reprezenta într-o formă cu care funcționează metodele Text Mining. Scopul unor astfel de transformări este de a elimina cuvintele inutile și de a da textului o formă mai strictă. Metodele de preprocesare vor fi descrise mai detaliat în secțiunea.

Extragerea informațiilor. Extragerea informațiilor din documentele selectate presupune identificarea conceptelor cheie din acestea, care vor fi analizate în viitor.

Aplicarea metodelor Text Mining. În acest pas sunt extrase modele și relații prezente în texte. Acest pas este cel principal în procesul de analiză a textului, iar problemele practice sunt rezolvate la acest pas.

Interpretarea rezultatelor. Ultimul pas în procesul de descoperire a cunoștințelor implică interpretarea constatărilor. De obicei, interpretarea constă fie în prezentarea rezultatelor în limbaj natural, fie în vizualizarea lor grafic.

Vizualizarea poate fi folosită și ca instrument de analiză a textului. Pentru a face acest lucru, conceptele cheie sunt extrase și prezentate grafic. Această abordare ajută utilizatorul să identifice rapid principalele subiecte și concepte și să determine importanța acestora.

Preprocesarea textului

Una dintre principalele probleme ale analizei textului este numărul mare de cuvinte dintr-un document. Dacă fiecare dintre aceste cuvinte este analizat, timpul de căutare a cunoștințelor noi va crește brusc și este puțin probabil să satisfacă cerințele utilizatorului. În același timp, este evident că nu toate cuvintele din text poartă informații utile. În plus, datorită flexibilității limbilor naturale, cuvintele diferite din punct de vedere formal (sinonime etc.) înseamnă de fapt aceleași concepte. Astfel, eliminarea cuvintelor neinformative, precum și aducerea cuvintelor care sunt apropiate ca înțeles de o singură formă, reduce semnificativ timpul de analiză a textului. Eliminarea problemelor descrise se realizează în etapa de preprocesare a textului.

Următoarele tehnici sunt de obicei folosite pentru a elimina cuvintele neinformative și pentru a crește rigoarea textelor:

Eliminarea cuvintelor stop. Cuvintele stop sunt cuvinte auxiliare și care conțin puține informații despre conținutul documentului.

Îndepărtarea este o căutare morfologică. Constă în convertirea fiecărui cuvânt în forma sa normală.

L-gramele sunt o alternativă la analiza morfologică și eliminarea cuvintelor stop. Ele vă permit să faceți textul mai strict, dar nu rezolvă problema reducerii numărului de cuvinte neinformative;

Conversie de caz. Această tehnică presupune convertirea tuturor caracterelor în majuscule sau minuscule.

Cea mai eficientă este utilizarea combinată a acestor metode.

Sarcini de extragere a textului

În prezent, în literatura de specialitate sunt descrise multe probleme aplicate care pot fi rezolvate folosind analiza documentelor text. Acestea includ sarcini clasice de Data Mining: clasificare, grupare și sarcini tipice doar pentru documentele text: adnotare automată, extragerea conceptelor cheie etc.

Clasificarea este o sarcină standard în domeniul Data Mining. Scopul său este de a defini pentru fiecare document una sau mai multe categorii predefinite cărora le aparține acest document. O caracteristică a problemei de clasificare este presupunerea că setul de documente clasificate nu conține „gunoaie”, adică fiecare dintre documente corespunde unei anumite categorii.

Un caz special al problemei de clasificare este problema determinării subiectului unui document.

Scopul grupării documentelor este de a identifica automat grupuri de documente similare din punct de vedere semantic dintr-un set fix dat. Rețineți că grupurile sunt formate numai pe baza asemănării în perechi a descrierilor documentelor și nu sunt specificate în prealabil caracteristicile acestor grupuri.

Adnotarea automată (rezumat) vă permite să scurtați textul, păstrându-i în același timp sensul. Soluția la această problemă este de obicei controlată de utilizator prin determinarea numărului de propoziții de extras sau a procentului de text extras în raport cu întregul text. Rezultatul include cele mai semnificative propoziții din text.

Scopul principal al extragerii caracteristicilor este identificarea faptelor și a relațiilor din text. În cele mai multe cazuri, aceste concepte sunt substantive și substantive comune: numele și prenumele persoanelor, numele organizațiilor etc. Algoritmii de extragere a conceptelor pot folosi dicționare pentru a identifica anumiți termeni și modele lingvistice pentru a-i defini pe alții.

Navigarea pe bază de text permite utilizatorilor să navigheze în documente pe baza subiectelor și a termenilor relevanți. Acest lucru se realizează prin identificarea conceptelor cheie și a unor relații între ele.

Analiza tendințelor vă permite să identificați tendințele în seturi de documente pe o perioadă de timp. O tendință poate fi folosită, de exemplu, pentru a detecta schimbări în interesele unei companii de la un segment de piață la altul.

Căutarea asociațiilor este, de asemenea, una dintre sarcinile principale ale Data Mining. Pentru a o rezolva, relațiile asociative dintre conceptele cheie sunt identificate într-un set dat de documente.

Există un număr destul de mare de varietăți ale problemelor enumerate, precum și metode de rezolvare a acestora. Acest lucru confirmă încă o dată importanța analizei textului. Restul acestui capitol discută soluții la următoarele probleme: extragerea conceptului cheie, clasificarea, gruparea și adnotarea automată.

Clasificarea documentelor text

Clasificarea documentelor text, precum și în cazul clasificării obiectelor, constă în atribuirea unui document uneia dintre clasele cunoscute anterior. Adesea, clasificarea în raport cu documentele text se numește clasificare sau rubricare. Evident, aceste denumiri provin din sarcina de sistematizare a documentelor în cataloage, categorii și titluri. În acest caz, structura directorului poate fi fie cu un singur nivel, fie pe mai multe niveluri (ierarhică).

În mod formal, sarcina clasificării documentelor text este descrisă de un set de seturi.

În problema clasificării este necesară construirea unei proceduri pe baza acestor date, care constă în găsirea categoriei celei mai probabile din setul C pentru documentul studiat.

Majoritatea metodelor de clasificare a textelor se bazează într-un fel sau altul pe presupunerea că documentele aparținând aceleiași categorii conțin aceleași caracteristici (cuvinte sau expresii), iar prezența sau absența unor astfel de caracteristici într-un document indică apartenența sau neapartenența acestuia la un subiect anume.

Un astfel de set de caracteristici este adesea numit dicționar, deoarece este format din lexeme care includ cuvinte și/sau fraze care caracterizează categoria.

Trebuie remarcat faptul că aceste seturi de caracteristici sunt o trăsătură distinctivă a clasificării documentelor text din clasificarea obiectelor în Data Mining, care sunt caracterizate printr-un set de atribute.

Decizia de a atribui documentul d categoriei c se ia pe baza intersectării caracteristicilor comune

Sarcina metodelor de clasificare este de a selecta cel mai bine astfel de caracteristici și de a formula reguli pe baza cărora se va lua o decizie privind atribuirea unui document unei categorii.

Instrumente pentru analiza informațiilor text

Instrumente Oracle - Oracle Text2

Începând cu versiunea Oracle 7.3.3, instrumentele de analiză a textului sunt parte integrantă a produselor Oracle. În Oracle, aceste instrumente au fost dezvoltate și au primit o nouă denumire - Oracle Text - un pachet software integrat într-un SGBD care vă permite să lucrați eficient cu interogări legate de texte nestructurate. În acest caz, procesarea textului este combinată cu capabilitățile oferite utilizatorului pentru lucrul cu baze de date relaționale. În special, utilizarea SQL a devenit posibilă la scrierea aplicațiilor de procesare a textului.

Sarcina principală pe care instrumentele Oracle Text vizează rezolvarea este sarcina de a căuta documente după conținutul lor - după cuvinte sau expresii, care, dacă este necesar, sunt combinate folosind operații booleene. Rezultatele căutării sunt ordonate după importanță, ținând cont de frecvența de apariție a cuvintelor de interogare în documentele găsite.

Instrumente de la IBM - Intelligent Miner for Text1

Produsul IBM Intelligent Miner for Text este un set de utilitare separate care pot fi lansate din linia de comandă sau din scripturi independent unul de celălalt. Sistemul conține o combinație a unor utilități pentru rezolvarea problemelor de analiză a informațiilor text.

IBM Intelligent Miner for Text combină un set puternic de instrumente bazate în principal pe mecanisme de regăsire a informațiilor, care este specificul întregului produs. Sistemul constă dintr-un număr de componente de bază care au o semnificație independentă în afara tehnologiei Text Mining:

Instrumente SAS Institute - Text Miner

Compania americană SAS Institute a lansat sistemul SAS Text Miner pentru compararea anumitor secvențe gramaticale și verbale în vorbirea scrisă. Text Miner este foarte versatil deoarece poate lucra cu documente text de diferite formate - în baze de date, sisteme de fișiere și mai departe pe web.

Text Miner oferă procesare logică a textului în mediul SAS Enterprise Miner. Acest lucru permite utilizatorilor să îmbogățească procesul de analiză a datelor prin integrarea informațiilor text nestructurate cu datele structurate existente, cum ar fi vârsta, venitul și modelele de cerere ale consumatorilor.

Puncte principale

Descoperirea cunoștințelor de text este procesul non-trivial de descoperire a unor modele cu adevărat noi, potențial utile și ușor de înțeles în datele text nestructurate.

Procesul de analiză a documentelor text poate fi reprezentat ca o succesiune de mai multe etape: căutarea informațiilor, prelucrarea prealabilă a documentelor, extragerea informațiilor, aplicarea metodelor Text Mining, interpretarea rezultatelor.

Următoarele tehnici sunt de obicei folosite pentru a elimina cuvintele neinformative și pentru a crește rigoarea textelor: eliminarea cuvintelor stop, stemming, L-grams, reducere de majuscule.

Sarcinile analizei informațiilor de text sunt: clasificarea, gruparea, adnotarea automată, extragerea conceptelor cheie, navigarea textului, analiza tendințelor, căutarea asocierilor etc.

Extragerea conceptelor cheie din texte poate fi considerată atât ca o sarcină aplicată separată, cât și ca o etapă separată a analizei textului. În acest din urmă caz, faptele extrase din text sunt folosite pentru a rezolva diverse probleme de analiză.

Procesul de extragere a conceptelor cheie folosind șabloane se desfășoară în două etape: în prima, faptele individuale sunt extrase din documente text cu ajutorul analizei lexicale, în a doua etapă, integrarea faptelor extrase și/sau derivarea unor fapte noi este realizată. efectuate.

Majoritatea metodelor de clasificare a textelor se bazează într-un fel sau altul pe presupunerea că documentele aparținând aceleiași categorii conțin aceleași caracteristici (cuvinte sau expresii), iar prezența sau absența unor astfel de caracteristici într-un document indică apartenența sau neapartenența acestuia la un subiect anume.

Majoritatea algoritmilor de grupare necesită ca datele să fie reprezentate într-un model de spațiu vectorial, care este utilizat pe scară largă pentru regăsirea informațiilor și utilizează o metaforă pentru a reflecta similitudinea semantică ca proximitate spațială.

Există două abordări principale pentru adnotarea automată a documentelor text: extragerea (selectarea celor mai importante fragmente) și generalizarea (folosind cunoștințele colectate anterior).

Concluzie

Exploatarea datelor este una dintre cele mai relevante și populare domenii ale matematicii aplicate. Procesele moderne de afaceri și de producție generează cantități uriașe de date și devine din ce în ce mai dificil pentru oameni să interpreteze și să răspundă la cantități mari de date care se schimbă dinamic în timpul rulării, cu atât mai puțin să prevină situațiile critice. „Data mining” pentru a extrage cunoștințe utile maxime din date multidimensionale, eterogene, incomplete, inexacte, contradictorii, indirecte. Vă ajută să faceți acest lucru în mod eficient dacă volumul de date este măsurat în gigaocteți sau chiar terabytes. Ajută la construirea de algoritmi care pot învăța să ia decizii în diverse domenii profesionale.

Instrumentele de exploatare a datelor protejează oamenii de supraîncărcarea de informații prin procesarea datelor operaționale în informații utile, astfel încât acțiunile potrivite să poată fi întreprinse la momentele potrivite.

Dezvoltarile aplicate se realizeaza in urmatoarele domenii: prognoza in sistemele economice; Automatizarea cercetării de marketing și analizei mediilor client pentru companii de producție, comerț, telecomunicații și Internet; automatizarea procesului de luare a deciziilor de credit și a evaluării riscului de credit; monitorizarea pietelor financiare; sisteme automate de tranzacționare.

Referințe

fonduri proprii si... Analiză

şi clasificarea pieţei moderne a sistemelor informaţionale care implementează discreţionare, mRezumat >> Informatică efectuate 1.3 Diferențierea rolurilor 6 2. Comparativ efectuate diverse tipuri de sisteme 7 Sisteme de operare... sisteme, inclusiv: politici de securitate și caracteristicile acestora, ... aplicații sau implementarea mai multor efectuate intelectual

date. Pe langa... Inteligent

abilitățile copiilor supradotați în legătură cu performanța școlarăTeză >> Psihologie , factori de ajustare etc., de asemenea... bonitatea împrumutatului pe baza dezvoltare. Pe baza teoretică Împrumutat folosind cluster, verbal problema cercetării a fost... a intelige fără Împrumutat folosind cluster, verbal structura sa psihologică. Decisiv pentru evaluare intelectual abilitățile este...

„Tehnologii de analiză a datelor: Data Mining. Exploatare vizuală. Text Mining, OLAP" A. A. Barseghyan.

M. S. Kupriyanov, V. V. Stenanenko, I. I. Kholod. - Ed. a II-a, revizuită. si suplimentare

http://inf.susu.ac.ru/~pollak/expert/G2/g2.htm - articol pe internet

http://www.piter.com/contents/978549807257/978549807257_p.pdf -Tehnologii de analiză a datelorTeză >> Bancar Împrumutat folosind cluster, verbal analiză , factori de ajustare etc., de asemenea... bonitatea împrumutatului pe baza Împrumutat folosind cluster, verbal intelectual Împrumutat folosind cluster, verbal Data Mining (cu... La etapa inițială efectuate analiză

Ce este data mining

Baza de date corporativă a oricărei întreprinderi moderne conține de obicei un set de tabele care stochează înregistrări despre anumite fapte sau obiecte (de exemplu, despre bunuri, vânzările acestora, clienți, conturi).

De regulă, fiecare intrare dintr-un astfel de tabel descrie un obiect sau un fapt specific. De exemplu, o intrare în tabelul de vânzări reflectă faptul că un astfel de produs a fost vândut unui astfel de client la acel moment de către un manager și, în general, nu conține nimic altceva decât această informație. Totuși, strângerea unui număr mare de astfel de înregistrări, acumulate pe parcursul mai multor ani, poate deveni o sursă de informații suplimentare, mult mai valoroase, care nu pot fi obținute pe baza unei înregistrări specifice, și anume, informații despre tipare, tendințe sau interdependențe între orice date. Exemple de astfel de informații sunt informații despre modul în care vânzările unui anumit produs depind de ziua săptămânii, ora din zi sau perioada anului, care categorii de clienți cumpără cel mai adesea acest produs sau acel produs, ce proporție de cumpărători ai unui anumit produs cumpără. un alt produs specific, care categorie de clienti nu ramburseaza cel mai adesea creditul acordat la timp.

Rețineți că statisticile matematice tradiționale, care au rămas pentru o lungă perioadă de timp principalul instrument de analiză a datelor, precum și instrumente pentru procesarea analitică online (OLAP), despre care am scris deja de mai multe ori (a se vedea materialele pe acest subiect pe CD-ul nostru) , nu poate fi întotdeauna utilizat cu succes pentru a rezolva astfel de probleme. De obicei, metodele statistice și OLAP sunt folosite pentru a testa ipotezele preformulate. Cu toate acestea, de multe ori formularea unei ipoteze se dovedește a fi cea mai dificilă sarcină la implementarea analizei de afaceri pentru luarea deciziilor ulterioare, deoarece nu toate tiparele din date sunt evidente la prima vedere.

Tehnologia modernă Data Mining se bazează pe conceptul de șabloane care reflectă modele inerente subeșantioanelor de date. Căutarea tiparelor este efectuată folosind metode care nu folosesc nicio ipoteză a priori despre aceste subeșantioane.

În timp ce analiza statistică sau OLAP pun de obicei întrebări precum „Care este numărul mediu de facturi neplătite în rândul clienților pentru acest serviciu?”, Data Mining implică de obicei răspunsul la întrebări precum „Există o categorie tipică de clienți neplătitori?”. În același timp, este răspunsul la a doua întrebare care oferă adesea o abordare mai netrivială a politicii de marketing și a organizării muncii cu clienții.

O caracteristică importantă a Data Mining-ului este natura non-standard și neevidentă a tiparelor căutate. Cu alte cuvinte, instrumentele Data Mining diferă de instrumentele de procesare a datelor statistice și instrumentele OLAP prin faptul că, în loc să verifice interdependențe asumate anterior de utilizatori, sunt capabile să găsească astfel de interdependențe în mod independent pe baza datelor disponibile și să construiască ipoteze despre natura lor.

Trebuie remarcat faptul că utilizarea instrumentelor de Data Mining nu exclude utilizarea instrumentelor statistice și a instrumentelor OLAP, deoarece rezultatele prelucrării datelor folosind acestea din urmă, de regulă, contribuie la o mai bună înțelegere a naturii tiparelor care ar trebui fi căutat.