Как работают поисковые роботы. Поисковые роботы - как они работают и что делают

Вопреки расхожему мнению, робот непосредственно не занимается какой-либо обработкой сканируемых документов. Он их только считывает и сохраняет, дальше их обработку осуществляют другие программы. Наглядное подтверждение можно получить, анализируя логи сайта, который индексируется в первый раз. При первом визите бот сначала запрашивает файл robots.txt, затем главную страницу сайта. То есть идет по единственной известной ему ссылке. На этом первый визит бота всегда и заканчивается. Через некоторое время (обычно на следующий день) бот запрашивает следующие страницы - по ссылкам, которые найдены на уже считанной странице. Дальше процесс продолжается в том же порядке: запрос страниц, ссылки на которые уже найдены - пауза на обработку считанных документов - следующий сеанс с запросом найденных ссылок.

Разбор страниц «на лету» означал бы значительно бо льшую ресурсоемкость робота и потери времени. Каждый сервер сканирования запускает множество процессов-ботов параллельно. Они должны действовать максимально быстро, чтобы успеть считывать новые страницы и повторно перечитывать уже известные. Поэтому боты только считывают и сохраняют документы. Все, что они сохраняют, ставится в очередь на обработку (разборку кода). Найденные при обработке страниц ссылки ставятся в очередь заданий для ботов. Так и идет непрерывное сканирование всей сети. Единственное, что бот может и должен анализировать «на лету» - это файл robots.txt, чтобы не запрашивать адреса, которые в нем запрещены. При каждом сеансе сканирования сайта робот в первую очередь запрашивает этот файл, а уже после него - все стоящие в очереди на сканирование страницы.

Виды поисковых роботов

У каждой поисковой системы есть свой набор роботов для различных целей.

В основном они различаются по функциональному назначению, хотя границы очень условны, и каждый поисковик понимает их по-своему. Системам только для полнотекстового поиска вполне достаточно одного робота на все случаи жизни. У тех поисковиков, которые заняты не только текстом, боты разделяются как минимум на две категории: для текстов и рисунков. Существуют также отдельные боты, занятые специфическими видами контента - мобильным, блоговым, новостным, видео и т.д.

Роботы Google

Все роботы Google носят общее название Googlebot. Основной робот-индексатор «представляется» так:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Этот бот занят сканированием HTML -страниц и прочих документов для основного поиска Google. Он же изредка считывает файлы CSS и JS - в основном это можно заметить на ранней стадии индексирования сайта, пока бот обходит сайт впервые. Принимаемые типы контента - все (Accept: */*).

Второй из основных ботов занят сканированием изображений с сайта. Он «представляется» просто:

Googlebot-Image/1.0

Еще в логах замечены как минимум три бота, занятых сбором контента для мобильной версии поиска. Поле User-agent всех трех оканчивается строкой:

(compatible; Googlebot-Mobile/2.1; +http://www.google.com/bot.html)

Перед этой строкой - модель мобильного телефона, с которой этот бот совместим. У замеченных ботов это модели телефонов Nokia, Samsung и iPhone. Принимаемые типы контента - все, но с указанием приоритетов:

Accept: application/vnd.wap.xhtml+xml,application/xhtml+xml;q=0.9,text/vnd.wap.wml;q=0.8,text/html;q=0.7,*/*;q=0.6

Роботы Яндекса

Из поисковиков, активно действующих в Рунете, самая большая коллекция ботов у Яндекса. В разделе помощи для вебмастеров можно найти официальный список всего паучьего личного состава. Приводить его здесь полностью нет смысла, поскольку в этом списке периодически происходят изменения.

Тем не менее, о самых важных для нас роботах Яндекса нужно упомянуть отдельно.

Основной индексирующий робот

на текущий момент зовется

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots)

Ранее представлялся как

Yandex/1.01.001 (compatible; Win16; I)

Считывает HTML -страницы сайта и другие документы для индексирования. Список принимаемых медиатипов ранее был ограничен:

Accept: text/html, application/pdf;q=0.1, application/rtf;q=0.1, text/rtf;q=0.1, application/msword;q=0.1, application/x-shockwave-flash;q=0.1, application/vnd.ms-excel;q=0.1, application/vnd.ms-powerpoint;q=0.1

С 31 июля 2009 года в этом списке было замечено существенное расширение (число типов почти удвоилось), а с 10 ноября 2009 года список укоротился до */* (все типы).

Этого робота живо интересует вполне определенный набор языков: русский, несколько менее украинский и белорусский, еще чуть меньше английский и совсем мало - все остальные языки.

Accept-Language: ru, uk;q=0.8, be;q=0.8, en;q=0.7, *;q=0.01

Робот-сканер изображений несет в поле User-agent строку:

Mozilla/5.0 (compatible; YandexImages/3.0; +http://yandex.com/bots)

Занимается сканированием графики разных форматов для поиска в картинках.

В отличие от Google, у Яндекса есть отдельные боты для обслуживания некоторых специальных функций общего поиска.

Робот-«зеркальщик»

Mozilla/5.0 (compatible; YandexBot/3.0; MirrorDetector; +http://yandex.com/bots)

Ничего особенно сложного не делает - периодически появляется и проверяет, совпадает ли главная страница сайта при обращении к домену с www. и без. Также проверяет параллельные домены-«зеркала» на совпадение. По-видимому, зеркалами и канонической формой доменов в Яндексе занимается отдельный программный комплекс, не связанный напрямую с индексированием. Иначе решительно нечем объяснить существование для этой цели отдельного бота.

Сборщик иконок favicon.ico

Mozilla/5.0 (compatible; YandexFavicons/1.0; +http://yandex.com/bots)

Периодически появляется и запрашивает иконку favicon.ico, которая потом появляется в поисковой выдаче рядом со ссылкой на сайт. По каким причинам эту обязанность не совмещает сборщик картинок, неизвестно. По-видимому, также имеет место отдельный программный комплекс.

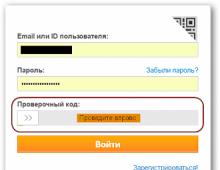

Проверочный бот для новых сайтов, работает при добавлении в форму AddURL

Mozilla/5.0 (compatible; YandexWebmaster/2.0; +http://yandex.com/bots)

Этот бот проверяет отклик сайта, посылая запрос HEAD к корневому URL . Таким образом проверяется существование главной страницы в домене и анализируются HTTP -заголовки этой страницы. Также бот запрашивает файл robots.txt в корне сайта. Таким образом после подачи ссылки в AddURL определяется, что сайт существует и ни в robots.txt, ни в HTTP -заголовках не запрещен доступ к главной странице.

Робот Рамблера

В настоящее время уже не работает

, поскольку Рамблер сейчас использует поиск Яндекса

Робота-индексатора Рамблера легко опознать в логах по полю User-agent

StackRambler/2.0 (MSIE incompatible)

По сравнению с «коллегами» из других поисковых систем этот бот кажется совсем простым: не указывает список медиатипов (соответственно, получает запрошенный документ любого типа), поле Accept-Language в запросе отсутствует, в запросах бота не встречено также поле If-Modified-since.

Робот Mail.Ru

Об этом роботе пока известно немного. Разработку собственного поиска портал Mail.Ru ведет уже давно, но все никак не соберется этот поиск запустить. Поэтому достоверно известно только наименование бота в User-agent - Mail.Ru/2.0 (ранее - Mail.Ru/1.0). Наименование бота для директив файла robors.txt нигде не публиковалось, есть предположение, что бота так и следует звать Mail.Ru.

Прочие роботы

Поиск в интернете, конечно, не ограничивается двумя поисковыми системами. Поэтому существуют и другие роботы - например робот Bing - поисковой системы от Microsoft и другие роботы. Так, в частности, в Китае есть национальная поисковая система Baidu - но ее робот вряд ли долетит до середины реки дойдет до русского сайта .

Кроме того, в последнее время расплодилось много сервисов - в частности solomono - которые хоть и не являются поисковыми системами, но тоже сканирует сайты. Часто ценность передачи информации о сайте таким системам сомнительна, и поэтому их роботов можно запретить в

Ежедневно в интернете появляется огромное количество новых материалов: создаются сайты, обновляются старые веб-страницы, загружаются фотографии и видеофайлы. Без невидимых поисковых роботов невозможно было бы найти во всемирной паутине ни один из этих документов. Альтернативы подобным роботизированным программам на данный момент времени не существует. Что такое поисковый робот, зачем он нужен и как функционируют?

Что такое поисковый робот

Поисковый робот сайтов (поисковых систем) - это автоматическая программа, которая способна посещать миллионы веб-страниц, быстро перемещаясь по интернету без вмешательства оператора. Боты постоянно сканируют пространство находят новые интернет-страницы и регулярно посещают уже проиндексированные. Другие названия поисковых роботов: пауки, краулеры, боты.

Зачем нужны поисковые роботы

Основная функция, которую выполняют поисковые роботы, - индексация веб-страниц, а также текстов, изображений, аудио- и видеофайлов, находящихся на них. Боты проверяют ссылки, зеркала сайтов (копии) и обновления. Роботы также осуществляют контроль HTML-кода на предмет соотвествия нормам Всемирной организации, которая разрабатывает и внедряет технологические стандарты для Всемирной паутины.

Что такое индексация и зачем она нужна

Индексация - это, собственно, и есть процесс посещения определенной веб-страницы поисковыми роботами. Программа сканирует тексты, размещенные на сайте, изображения, видео, исходящие ссылки, после чего страница появляется в результатах поиска. В некоторых случаях сайт не может быть просканирован автоматически, тогда он может быть добавлен в поисковую систему вручную веб-мастером. Как правило, это происходит при отсутствии на определенную (часто только недавно созданную) страницу.

Как работают поисковые роботы

Каждая поисковая система имеет собственного бота, при этом поисковый робот Google может значительно отличаться по механизму работы от аналогичной программы "Яндекса" или других систем.

В общих чертах принцип работы робота заключается в следующем: программа «приходит» на сайт по внешним ссылкам и, начиная с главной страницы, «читает» веб-ресурс (в том числе просматривая те служебные данные, которые не видит пользователь). Бот может как перемещаться между страницами одного сайта, так и переходить на другие.

Как программа выбирает, какой Чаще всего «путешествие» паука начинается с новостных сайтов или крупных ресурсов, каталогов и агрегаторов с большой ссылочной массой. Поисковый робот непрерывно сканирует страницы одну за другой, на скорость и последовательность индексации влияют следующие факторы:

- внутренние : перелиновка (внутренние ссылки между страницами одного и того же ресурса), размер сайта, правильность кода, удобство для пользователей и так далее;

- внешние : общий объем ссылочной массы, которая ведет на сайт.

Первым делом поисковый робот ищет на любом сайте файл robots.txt. Дальнейшая индексация ресурса проводится, основываясь на информации, полученной именно от этого документа. Файл содержит точные инструкции для "пауков", что позволяет повысить шансы посещения страницы поисковыми роботами, а следовательно, и добиться скорейшего попадания сайта в выдачу "Яндекса" или Google.

Программы-аналоги поисковых роботов

Часто понятие «поисковый робот» путают с интеллектуальными, пользовательскими или автономными агентами, "муравьями" или "червями". Значительные отличия имееются только по сравнению с агентами, другие определения обозначают схожие виды роботов.

Так, агенты могут быть:

- интеллектуальными : программы, которые перемещаются от сайта к сайту, самостоятельно решая, как поступать дальше; они мало распространены в интернете;

- автономными : такие агенты помогают пользователю в выборе продукта, поиске или заполнении форм, это так называемые фильтры, которые мало относятся к сетевым программам.;

- пользовательскими : программы способствуют взаимодействию пользователя со Всемирной паутиной, это браузеры (например, Opera, IE, Google Chrome, Firefox), мессенджеры (Viber, Telegram) или почтовые программы (MS Outlook или Qualcomm).

"Муравьи" и "черви" больше схожи с поисковыми "пауками". Первые образуют между собой сеть и слаженно взаимодействуют подобно настоящей муравьиной колонии, "черви" же способны самовоспроизводиться, в остальном действуют так же, как и стандартный поисковый робот.

Разновидности поисковых роботов

Различают множество разновидностей поисковых роботов. В зависимости от назначения программы они бывают:

- «Зеркальными» - просматривают дубликаты сайтов.

- Мобильными - нацелены на мобильные версии интернет-страниц.

- Быстродействующими - фиксируют новую информацию оперативно, просматривая последние обновления.

- Ссылочными - индексируют ссылки, подсчитывают их количество.

- Индексаторами различных типов контента - отдельных программ для текста, аудио- и видеозаписей, изображений.

- «Шпионскими» - ищут страницы, которые еще не отображаются в поисковой системе.

- «Дятлами» - периодически посещают сайты, чтобы проверить их актуальность и работоспособность.

- Национальными - просматривают веб-ресурсы, расположенные на доменах одной страны (например, .ru, .kz или.ua).

- Глобальными - индексируют все национальные сайты.

Роботы основных поисковых систем

Существуют также отдельные роботы поисковых систем. В теории их функциональность может значительно различаться, но на практике программы практически идентичны. Основные отличия индексации интернет-страниц роботами двух основных поисковых систем состоят в следующем:

- Строгость проверки. Считается, что механизм поискового робота "Яндекса" несколько строже оценивает сайт на соответствие стандартам Всемирной паутины.

- Сохранение целостности сайта. Поисковый робот Google индексирует сайт целиком (в том числе медиаконтент), "Яндекс" же может просматривать страницы выборочно.

- Скорость проверки новых страниц. Google добавляет новый ресурс в поисковую выдачу в течение нескольких дней, в случае с "Яндексом" процесс может растянуться на две недели и более.

- Частота переиндексации. Поисковый робот "Яндекса" проверяет наличие обновлений пару раз в неделю, а Google - один раз в 14 дней.

Интернет, конечно же, не ограничивается двумя поисковыми системами. Другие поисковики имеют своих роботов, которые следуют собственным параметрам индексации. Кроме того, существует несколько "пауков", которые разработаны не крупными поисковыми ресурсами, а отдельными командами или веб-мастерами.

Распространенные заблуждения

Вопреки распространенному мнению, "пауки" не обрабатывают полученную информацию. Программа только сканирует и сохраняет веб-страницы, а дальнейшей обработкой занимаются совершенно другие роботы.

Также многие пользователи считают, что поисковые роботы оказывают негативное воздействие и «вредны» интернету. Действительно, отдельные версии "пауков" могут значительно перегружать сервера. Имеет место и человеческий фактор - веб-мастер, который создавал программу, может допускать ошибки в настройках робота. Все же большинство действующих программ хорошо спроектированы и профессионально управляются, а любые возникающие неполадки оперативно устраняются.

Как управлять индексацией

Поисковые роботы являются автоматическими программами, но процесс индексации может частично контролироваться веб-мастером. В этом значительно помогает внешняя и ресурса. Кроме того, можно вручную добавить новый сайт в поисковую систему: крупные ресурсы имеют специальные формы регистрации веб-страниц.

Роботы поисковой системы, иногда их называют «пауки» или «кроулеры» (crawler) — это программные модули, занимающиеся поиском web-страниц. Как они работают? Что же они делают в действительности? Почему они важны?

Учитывая весь шум вокруг поисковой оптимизации и индексных баз данных поисковиков, вы, наверное думаете, что роботы должно быть великие и могущественные существа. Неправда. Роботы поисковика обладают лишь базовыми функциями, похожими на те, которыми обладали одни из первых броузеров, в отношении того, какую информацию они могут распознать на сайте. Как и ранние броузеры, роботы попросту не могут делать определенные вещи. Роботы не понимают фреймов, Flash анимаций, изображений или JavaScript. Они не могут зайти в разделы, защищенные паролем и не могут нажимать на все те кнопочки, которые есть на сайте. Они могут «заткнуться» в процессе индексирования динамических адресов URL и работать очень медленно, вплоть до остановки и безсилием над JavaScript-навигацией.

Как работают роботы поисковой машины?

Поисковые роботы стоит воспринимать, как программы автоматизированного получения данных, путешествующие по сети в поисках информации и ссылок на информацию.

Когда, зайдя на страницу «Submit a URL», вы регистрируете очередную web-страницу в поисковике — в очередь для просмотра сайтов роботом добавляется новый URL. Даже если вы не регистрируете страницу, множество роботов найдет ваш сайт, поскольку существуют ссылки из других сайтов, ссылающиеся на ваш. Вот одна из причин, почему важно строить ссылочную популярность и размещать ссылки на других тематических ресурсах.

Прийдя на ваш сайт, роботы сначала проверяют, есть ли файл robots.txt. Этот файл сообщает роботам, какие разделы вашего сайта не подлежат индексации. Обычно это могут быть директории, содержащие файлы, которыми робот не интересуется или ему не следовало бы знать.

Роботы хранят и собирают ссылки с каждой страницы, которую они посещают, а позже проходят по этим ссылкам на другие страницы. Вся всемирная сеть построена из ссылок. Начальная идея создания Интернет сети была в том, что бы была возможность перемещаться по ссылкам от одного места к другому. Вот так перемещаются и роботы.

«Остроумность» в отношении индексирования страниц в реальном режиме времени зависит от инженеров поисковых машин, которые изобрели методы, используемые для оценки информации, получаемой роботами поисковика. Будучи внедрена в базу данных поисковой машины, информация доступна пользователям, которые осуществляют поиск. Когда пользователь поисковой машины вводит поисковый запрос, производится ряд быстрых вычислений для уверенности в том, что выдается действительно правильный набор сайтов для наиболее релевантного ответа.

Вы можете просмотреть, какие страницы вашего сайта уже посетил поисковый робот, руководствуясь лог-файлами сервера, или результатами статистической обработки лог-файла. Идентифицируя роботов, вы увидите, когда они посетили ваш сайт, какие страницы и как часто. Некоторые роботы легко идентифицируются по своим именам, как Google’s «Googlebot». Другие более скрытые, как, например, Inktomi’s «Slurp». Другие роботы так же могут встречаться в логах и не исключено, что вы не сможете сразу их идентифицировать; некоторые из них могут даже оказаться броузерами, которыми управляют люди.

Помимо идентификации уникальных поисковых роботов и подсчета количества их визитов, статистика также может показать вам агрессивных, поглощающих ширину катала пропускания роботов или роботов, нежелательных для посещения вашего сайта.

Как они читают страницы вашего web-сайта?

Когда поисковой робот посещает страницу, он просматривает ее видимый текст, содержание различных тегов в исходном коде вашей страницы (title tag, meta tags, и т.д.), а так же гиперссылки на странице. Судя по словам ссылок, поисковая машина решает, о чем страница. Есть много факторов, используемых для вычисления ключевых моментов страницы «играющих роль». Каждая поисковая машина имеет свой собственный алгоритм для оценки и обработки информации. В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базу данных поисковой системы.

После этого, информация, доставленная в индексные базы данных поисковой системы, становится частью поисковика и процесса ранжирования в базе. Когда посетитель существляет запрос, поисковик просматривает всю базу данных для выдачи конечного списка, релевантного поисковому запросу.

Базы данных поисковых систем подвергаются тщательной обработке и приведению в соответствие. Если вы уже попали в базу данных, роботы будут навещать вас периодически для сбора любых изменений на страницах и уверенности в том, что обладают самой последней информацией. Количество посещений зависит от установок поисковой машины, которые могут варьироваться от ее вида и назначения.

Иногда поисковые роботы не в состоянии проиндексировать web-сайт. Если ваш сайт упал или на сайт идет большое количество посетителей, робот может быть безсилен в попытках его индексации. Когда такое происходит, сайт не может быть переиндексирован, что зависит от частоты его посещения роботом. В большинстве случаев, роботы, которые не смогли достичь ваших страниц, попытаются позже, в надежде на то, что ваш сайт в ближайшее время будет доступен.

Многие поисковые роботы не могут быть идентифицированы, когда вы просматриваете логи. Они могут посещать вас, но логи утверждают, что кто-то использует Microsoft броузер и т.д. Некоторые роботы идентифицируют себя использованием имени поисковика (googlebot) или его клона (Scooter = AltaVista).

В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базы данных поисковой машины.

Базы данных поисковых машин подвергаются модификации в различные сроки. Даже директории, имеющие вторичные поисковые результаты используют данные роботов как содержание своего web-сайта.

Собственно, роботы не используются поисковиками лишь для вышеизложенного. Существуют роботы, которые проверяют баз данных на наличие нового содержания, навещают старое содержимое базы, проверяют, не изменились ли ссылки, загружают целые сайты для просмотра и так далее.

По этой причине, чтение лог-файлов и слежение за выдачей поисковой системы помогает вам наблюдать за индексацией ваших проектов.

маркетинга и сервисная программа торговли ссылками в Интернете, которая не имеет себе конкурентов по качеству, многофункциональности и характеристикам – Zeus – это лучшая программа Интернет маркетинга. ... Наш опциональный zSearch превращает Zeus в полноценную поисковую систему.

Он действует как робот поисковых машин (Googlebot, MSNBot, WISENutbot, Alexa, и др. ... Fast Link Checker игнорирует все Gopher, News and mailto: ссылки. ... Fast Link Checker поддерживает HTTP, HTTPS, и SOCKS прокси-сервера. ... В программе Fast Link Checker реализован многопотоковый алгоритм работы с файлами, это обеспечивает одновременную загрузку и проверку сразу нескольких страниц,...

Оптимизированный ASP сценарий обмена ссылками веб директории от Pro Data Doctor – это дружественная поисковая система и данный сценарий был разработан в соответствии с требованиями оптимизации SEO по поисковым системам. ... - Код поддерживает сохранение неограниченного количества обратных ссылок, что увеличивает ваш рейтинг в поисковых системах.

Включает персонального поискового робота для автоматического поиска тем в Интернете для вас. ... Распределяйте ваши знания, используя поискового бота. ... My SearchBot найдет вам все, что можно просмотреть, сохранить и потом распределить по папкам. ... Включая встроенный брандмауэр и программу безопасности – данная программа защитит вас от всех возможных угроз одним щелчком.

Функционал: статистика в реальном времени; 64 отчета (14 бесплатно); загрузки файлов; роботы ; статистика RSS-каналов; ссылки; поисковые фразы; сегментация аудитории сайта; метрика конверсии посетителей; страны, регионы, города, организации; метрика веб-сервера; многопользовательский режим; супер-компактная база данных; платформо-независимость; бесплатная версия; и многое другое.

Txt Generator: - Поддержка до 300 Роботов и Поисковых агентов. ... - Неограниченное количество комбинаций для управления Роботом . ... - WYSIWYG выборка исключения Роботов и файла/директории. ... - Автоматическая загрузка на web-сервер. ... - Неограниченное количество проектов и web-сайтов. ... - Документация в режиме онлайн или оффлайн.

С помощью IIS Mod-Rewrite Pro вы можете манипулировать URL на лету, создавать ваши собственные поисковые системы веб-сайта, делать перенаправления, блокировать определенные URL, блокировать раздражительные роботы и многое другое. ... Также программа выходит с богатой функцией панелью управления, которая включает онлайн обновления, возвраты версии, диагностику, тестер regex и множество других...

Web Log Suite также позволяет вам фильтровать посещения роботов поисковых систем. ... Данная программа будет предоставлять вам информацию о посетителях веб сайтов, статистику деятельности, статистику доступа к файлам, информацию о обращающихся страницах, поисковых системах, ошибках, странах посетителей, обращающихся веб сайтах, вы сможете получить информацию о поисковых словах и фразах и...

Привет, Друзья! Сегодня Вы узнаете как работают поисковые роботы Яндекс и Google и какую функцию они выполняют в продвижении сайтов. Итак поехали!

Это действие поисковые системы делают для того, чтобы из миллиона сайтов найти десять WEB-проектов, которые имеют качественный и релевантный ответ на запрос пользователя. Почему только десять? Потому что состоит только из десяти позиций.

Поисковые роботы друзья и веб-мастерам и пользователям

Почему важно посещения сайта поисковыми роботами уже стало ясно, а зачем это пользователю? Всё верно, для того, чтобы пользователю открывались только те сайты, которые ответят на его запрос в полном объёме.

Поисковый робот – очень гибкий инструмент, он способен найти сайт, даже тот, который только создан, а владелец этого сайта ещё не занимался . Поэтому этого бота и назвали пауком, он может дотянуть свои лапки и добраться по виртуальной паутине куда угодно.

Можно ли управлять поисковым роботом в своих интересах

Бывают такие случаи, когда некоторые страницы не попали в поиск. В основном это связано с тем, что эта страница ещё не проиндексирована поисковым роботом. Конечно, рано или поздно поисковый робот заметит эту страницу. Но это требует времени, а иногда и достаточно много времени. Но здесь можно помочь поисковому роботу посетить эту страницу быстрее.

Для этого можно разместить свой сайт в специальных каталогах или списках, социальных сетях. В общем, на всех площадках, где поисковый робот просто живёт. Например, в социальных сетях идёт обновление каждую секунду. Попробуйте заявить о своём сайте, и поисковый робот придёт на ваш сайт значительно быстрее.

Из этого вытекает одно, но главное правило. Если вы хотите чтобы боты поисковой системы посещали ваш сайт, им нужно давать новый контент на регулярной основе. В том случае, если они заметит, что контент обновляется, сайт развивается, то станут посещать ваш интернет-проект намного чаще.

Каждый поисковый робот умеет запоминать, как часто у вас меняется контент. Он оценивает не только качество, а временные промежутки. И если материал на сайте обновляется раз в месяц, то и приходить он на сайт будет один раз в месяц.

Таким образом, если сайт будет обновляться раз в неделю, то и поисковый робот будет приходить раз в неделю. Если обновлять сайт каждый день, то и поисковый робот будет посещать сайт каждый день или через день. Есть сайты, которые индексируются уже через несколько минут после обновления. Это социальные сети, новостные агрегаторы, и сайты которые размещают в день несколько статей.

Как дать задание роботу и запретить ему что-либо?

В самом начале мы узнали, что поисковые системы имеют несколько роботов, которые выполняют различные задачи. Кто-то ищет картинки, кто-то ссылки так далее.

Управлять любым роботом можно с помощью специального файла robots.txt . Именно с этого файла робот начинает знакомиться с сайтом. В этом файле можно указать, можно ли роботу индексировать сайт, если да, то какие именно разделы. Все эти инструкции можно создать как для одного, так и для всех роботов.

Обучение продвижению сайтов

Более подробно о премудростях SEO продвижения сайтов в поисковых системах Google и Яндекс, я рассказываю на своих по скайпу. Все свои WEB-проекты я вывел на посещаемость более и получаю с этого отличный . Могу этому научить и Вас, кому интересно!